手搓大模型Task02:从零预训练一个 tiny-llama

前言

从零开始训练 tiny-llama。Llama3 相较于 llama2 在 model 层面上主要区别是全模型使用 GQA,在分词阶段使用的与 GPT 一致的 tiktoken。

源码地址:https://github.com/lixinjie97/tiny-universe/tree/main/02.TinyLlama

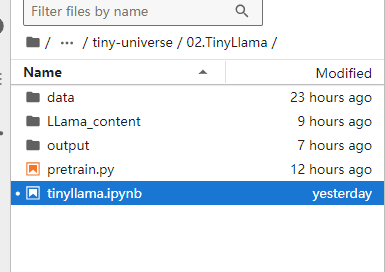

1.项目目录

注:一定要创建output文件夹,否则有错误。

训练命令:

python pretrain.py2.训练

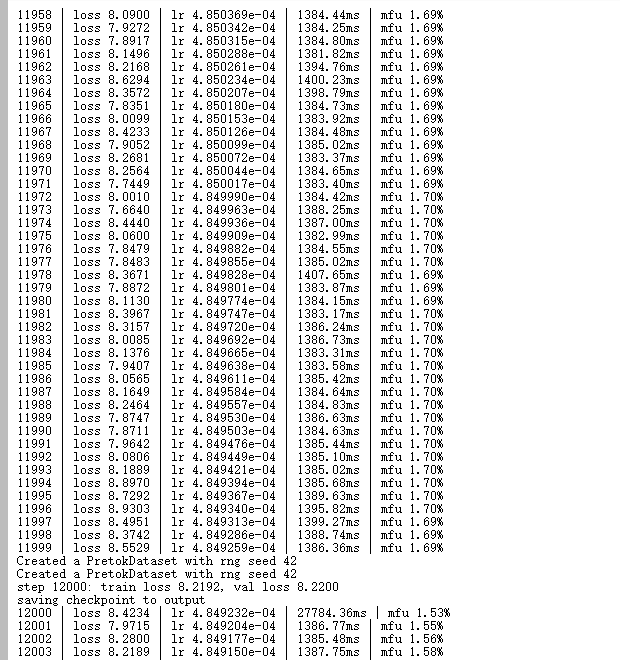

机器:4060ti

显存消耗:8G

训练时长:24h

训练过程:

3.总结

本实验采用了 tiny_story 数据集,使用的是已经分词好的样例数据,可以先体验 pretrain 与模型推理的过程,后面会更新数据分词教程。