宝典

宝典

一、基础知识

输入与输出

a=1,b=2,不用中间变量交换 a 和 b 的值?

方法一:

1. a = a+b

2. b = a-b

3. a = a-b

方法二:

1. a = a^b

2. b =b^a

3. a = a^b

方法三:

1. a,b = b,a

print 调用 Python 中底层的什么方法?

print 方法默认调用 sys.stdout.write 方法,即往控制台打印字符串。

代码中要修改不可变数据会出现什么问题? 抛出什么异常?

代码不会正常运行,抛出 TypeError 异常。

下面这段代码的输出结果将是什么?请解释?

1. class Parent(object):

2. x = 1

3. class Child1(Parent):

4. pass

5. class Child2(Parent):

6. pass

7. print(Parent.x, Child1.x, Child2.x) #1 1 1

8. Child1.x = 2

9. print(parent.x, Child1.x, Child2.x) #1 2 1

10. parent.x = 3

11. print(Parent.x, Child1.x, Child2.x) #3 2 3

结果为:

1、#继承自父类的类属性 x,所以都一样,指向同一块内存地址。

2、#更改 Child1,Child1 的 x 指向了新的内存地址。

3、#更改 Parent,Parent 的 x 指向了新的内存地址。

简述你对 input()函数的理解?

在 Python3 中,input()获取用户输入,不论用户输入的是什么,获取到的都是字符串类型的。

条件与循环

阅读下面的代码,写出 A0,A1 至 An 的最终值

1. A0 = dict(zip(('a','b','c','d','e'),(1,2,3,4,5)))

2. A1 = range(10)

3. A2 = [i for i in A1 if i in A0]

4. A3 = [A0[s] for s in A0]

5. A4 = [i for i in A1 if i in A3]

6. A5 = {i:i*i for i in A1}

7. A6 = [[i,i*i] for i in A1]

答:

1. A0 = {'a': 1, 'c': 3, 'b': 2, 'e': 5, 'd': 4}

2. A1 = [0, 1, 2, 3, 4, 5, 6, 7, 8, 9]

3. A2 = []

4. A3 = [1, 3, 2, 5, 4]

5. A4 = [1, 2, 3, 4, 5]

6. A5 = {0: 0, 1: 1, 2: 4, 3: 9, 4: 16, 5: 25, 6: 36, 7: 49, 8: 64, 9: 81}

7. A6 = [[0, 0], [1, 1], [2, 4], [3, 9], [4, 16], [5, 25], [6, 36],[7, 49],[8, 64], [9,81]]

以下 Python 程序的输出?

1. for i in range(5,0,-1):

2. print(i)

答:

5 4 3 2 1

文件操作

4G内存怎么读取一个5G的数据?

方法一:

可以通过生成器,分多次读取,每次读取数量相对少的数据(比如 500MB)进行处理,处理结束后再读取后面的 500MB 的数据。

方法二:

可以通过 linux 命令 split 切割成小文件,然后再对数据进行处理,此方法效率比较高。可以按照行数切割,可以按照文件大小切割。

现在考虑有一个 jsonline 格式的文件 file.txt 大小约为 10K,之前处理文件的代码如下所示:

1. def get_lines():

2. l = []

3. with open(‘file.txt’,‘rb’) as f:

4. for eachline in f:

5. l.append(eachline)

6. return l

7. if __name__ == ‘__main__’:

8. for e in get_lines():

9. process(e) #处理每一行数据

现在要处理一个大小为 10G 的文件,但是内存只有4G,如果在只修改 get_lines 函数而其他代码保持不变的情况下,应该如何实现?需要考虑的问题都有哪些?

1. def get_lines():

2. l = []

3. with open(‘file.txt’,’rb’) as f:

4. data = f.readlines(60000)

5. l.append(data)

6. yield l

要考虑到的问题有:

内存只有 4G 无法一次性读入 10G 的文件,需要分批读入。分批读入数据要记录每次读入数据的位置。分批每次读入数据的大小,太小就会在读取操作上花费过多时间。

read、readline 和 readlines 的区别?

- read:读取整个文件。

- readline:读取下一行,使用生成器方法。

- readlines:读取整个文件到一个迭代器以供我们遍历。

异常

在 except中 return后还会不会执行 finally中的代码?怎么抛出自定义异常?

会继续处理 finally 中的代码;用 raise 方法可以抛出自定义异常。

介绍一下 except 的作用和用法?

except: #捕获所有异常

except: <异常名>: #捕获指定异常

except:<异常名 1, 异常名 2> : 捕获异常1或者异常2

except:<异常名>,<数据>:捕获指定异常及其附加的数据

except:<异常名 1,异常名 2>:<数据>:捕获异常名1或者异常名2及附加的数据

模块与包

常用的 Python 标准库都有哪些?

os 操作系统,time 时间,random 随机,pymysql 连接数据库,threading 线程,multiprocessing 进程,queue 队列。

第三方库:django 和 flask 也是第三方库,requests,virtualenv,selenium,scrapy,xadmin,celery,re,hashlib,md5。

常用的科学计算库(如 Numpy,Scipy,Pandas)。

赋值、浅拷贝和深拷贝的区别?

-

赋值

在 Python 中,对象的赋值就是简单的对象引用,这点和 C++不同,如下所示:

a = [1,2,"hello",['python', 'C++']] b = a在上述情况下,a 和 b 是一样的,他们指向同一片内存,b 不过是 a 的别名,是引用。

我们可以使用

b is a去判断,返回 True,表明他们地址相同,内容相同,也可以使用 id()函数来查看两个列表的地址是否相同。赋值操作(包括对象作为参数、返回值)不会开辟新的内存空间,它只是复制了对象的引用。也就是说除了 b 这个名字之外,没有其他的内存开销。修改了 a,也就影响了 b,同理,修改了 b,也就影响了 a。

-

浅拷贝(shallow copy)

浅拷贝会创建新对象,其内容非原对象本身的引用,而是原对象内第一层对象的引用。

浅拷贝有三种形式:切片操作、工厂函数、copy 模块中的 copy 函数。比如上述的列表 a;

-

切片操作:

b = a[:]或者b = [x for x in a]; -

工厂函数:

b = list(a); -

copy 函数:

b = copy.copy(a);

浅拷贝产生的列表 b 不再是列表 a 了,使用 is 判断可以发现他们不是同一个对象,使用 id 查看,他们也不指向同一片内存空间。但是当我们使用

id(x) for x in a和id(x) for x in b来查看 a 和 b 中元素的地址时,可以看到二者包含的元素的地址是相同的。在这种情况下,列表 a 和 b 是不同的对象,修改列表 b 理论上不会影响到列表 a。

但是要注意的是,浅拷贝之所以称之为浅拷贝,是它仅仅只拷贝了一层,在列表 a 中有一个嵌套的list,如果我们修改了它,情况就不一样了。

比如:

a[3].append('java')。查看列表 b,会发现列表 b 也发生了变化,这是因为我们修改了嵌套的 list,修改外层元素,会修改它的引用,让它们指向别的位置,修改嵌套列表中的元素,列表的地址并未发生变化,指向的都是用一个位置。 -

-

深拷贝(deep copy)

深拷贝只有一种形式,copy 模块中的 deepcopy()函数。

深拷贝和浅拷贝对应,深拷贝拷贝了对象的所有元素,包括多层嵌套的元素。因此,它的时间和空间开销要高。

同样的对列表 a,如果使用 b = copy.deepcopy(a),再修改列表 b 将不会影响到列表 a,即使嵌套的列表具有更深的层次,也不会产生任何影响,因为深拷贝拷贝出来的对象根本就是一个全新的对象,不再与原来的对象有任何的关联。

拷贝的注意点:对于不可变数据类型,如数字、字符,以及其他的“原子”类型,没有拷贝一说,产生的都是原对象的引用。如果可变数据类型包含不可变数据类型,即使采用了深拷贝,也只能得到浅拷贝。

Python 里面如何生成随机数?

Python 中用于生成随机数的模块是 random,在使用前需要 import。如下例子可以酌情列举:

-

random.random():生成一个 0-1 之间的随机浮点数;

-

random.uniform(a, b):生成[a,b]之间的浮点数;

-

random.randint(a, b):生成[a,b]之间的整数;

-

random.randrange(a, b, step):在指定的集合[a,b)中,以 step 为基数随机取一个数;

-

random.shuffle(lst): 将序列的所有元素随机排序;

-

random.choice(sequence):从特定序列中随机取一个元素,这里的序列可以是字符串,列表,元组等;

输入某年某月某日,判断这一天是这一年的第几天?(可以用 Python 标准库)

1. import datetime

2. def dayofyear():

3. year = input("请输入年份:")

4. month = input("请输入月份:")

5. day = input("请输入天:")

6. date1 = datetime.date(year=int(year),month=int(month),day=int(day))

7. date2 = datetime.date(year=int(year),month=1,day=1)

8. return (date1 - date2 + 1).days

说明一下 os.path 和 sys.path 分别代表什么?

os.path 主要是用于对系统路径文件的操作。

sys.path 主要是对 Python 解释器的系统环境参数的操作(动态的改变 Python 解释器搜索路径)。

Python 中的 os 模块常见方法?

- os.remove()删除文件

- os.rename()重命名文件

- os.walk()生成目录树下的所有文件名

- os.chdir()改变目录

- os.mkdir/makedirs 创建目录/多层目录

- os.rmdir/removedirs 删除目录/多层目录

- os.listdir()列出指定目录的文件

- os.getcwd()取得当前工作目录

- os.chmod()改变目录权限

- os.path.basename()去掉目录路径,返回文件名

- os.path.dirname()去掉文件名,返回目录路径

- os.path.join()将分离的各部分组合成一个路径名

- os.path.split()返回(dirname(),basename())元组

- os.path.splitext()(返回 filename,extension)元组

- os.path.getatime\ctime\mtime 分别返回最近访问、创建、修改时间

- os.path.getsize()返回文件大小

- os.path.exists()是否存在

- os.path.isabs()是否为绝对路径

- os.path.isdir()是否为目录

- os.path.isfile()是否为文件

更多详见:

Python3 OS 文件/目录方法

os.path

os--- 多种操作系统接口

os.path--- 常用路径操作

Python 的 sys 模块常用方法?

- sys.argv 命令行参数 List,第一个元素是程序本身路径

- sys.modules.keys() 返回所有已经导入的模块列表

- sys.exc_info() 获取当前正在处理的异常类,exc_type、exc_value、exc_traceback 当前处理的异常详细信息

- sys.exit(n) 退出程序,正常退出时

exit(0) - sys.hexversion 获取 Python 解释程序的版本值,16 进制格式如:0x020403F0

- sys.version 获取 Python 解释程序的版本信息

- sys.maxint 最大的 Int 值

- sys.maxunicode 最大的 Unicode 值

- sys.modules 返回系统导入的模块字段,key 是模块名,value 是模块

- sys.path 返回模块的搜索路径,初始化时使用 PYTHONPATH 环境变量的值

- sys.platform 返回操作系统平台名称

- sys.stdout 标准输出

- sys.stdin 标准输入

- sys.stderr 错误输出

- sys.exc_clear() 用来清除当前线程所出现的当前的或最近的错误信息

- sys.exec_prefix 返回平台独立的 python 文件安装的位置

- sys.byteorder 本地字节规则的指示器,big-endian 平台的值是'big',little-endian 平台的值是'little'

- sys.copyright 记录 python 版权相关的东西

- sys.api_version 解释器的 C 的 API 版本

- sys.version_info 元组则提供一个更简单的方法来使你的程序具备 Python 版本要求功能

更多详见:

sys--- 系统相关的参数和函数

unittest 是什么?

在 Python 中,unittest 是 Python 中的单元测试框架。它拥有支持共享搭建、自动测试、在测试中暂停代码、将不同测试迭代成一组等的功能。

模块和包是什么?

在 Python 中,模块是搭建程序的一种方式。每一个 Python 代码文件都是一个模块,并可以引用其他的模块,比如对象和属性。

一个包含许多 Python 代码的文件夹是一个包。一个包可以包含模块和子文件夹。

Python 特性

什么是 Python?

Python 是一种编程语言,它有对象、模块、线程、异常处理和自动内存管理,可以加入其他语言的对比。

Python 是一种解释型语言,Python 在代码运行之前不需要解释。

Python 是动态类型语言,在声明变量时,不需要说明变量的类型。

Python 适合面向对象的编程,因为它支持通过组合与继承的方式定义类。

在 Python 语言中,函数是第一类对象。

Python 代码编写快,但是运行速度比编译型语言通常要慢。

Python 用途广泛,常被用走"胶水语言",可帮助其他语言和组件改善运行状况。

使用 Python,程序员可以专注于算法和数据结构的设计,而不用处理底层的细节。

Python 是强语言类型还是弱语言类型?

Python 是强类型的动态脚本语言。

强类型:不允许不同类型相加。

动态:不使用显示数据类型声明,且确定一个变量的类型是在第一次给它赋值的时候。

脚本语言:一般也是解释型语言,运行代码只需要一个解释器,不需要编译。

什么是 Python 自省?

Python 自省是 Python 具有的一种能力,使程序员面向对象的语言所写的程序在运行时,能够获得对象的 Python 类型。Python 是一种解释型语言,为程序员提供了极大的灵活性和控制力。

Python 中的作用域?

Python 中,一个变量的作用域总是由在代码中被赋值的地方所决定。当 Python 遇到一个变量的话。它会按照这的顺序进行搜索:

本地作用域(Local)--->当前作用域被嵌入的本地作用域(Enclosing locals)--->全局/模块作用域

(Global)--->内置作用域(Built-in)。

什么是 Python 的命名空间?

在 Python 中,所有的名字都存在于一个空间中,它们在该空间中存在和被操作——这就是命名空间。它就好像一个盒子,每一个变量名字都对应装着一个对象。当查询变量的时候,会从该盒子里面寻找相应的对象。

谈一下什么是解释性语言,什么是编译性语言?

计算机不能直接理解高级语言,只能直接理解机器语言,所以必须要把高级语言翻译成机器语言,计算机才能执行高级语言编写的程序。

解释性语言在运行程序的时候才会进行翻译。

编译型语言写的程序在执行之前,需要一个专门的编译过程,把程序编译成机器语言(可执行文件)。

Python 中有日志吗?怎么使用?

有日志。

Python 自带 logging 模块,调用 logging.basicConfig()方法,配置需要的日志等级和相应的参数,Python 解释器会按照配置的参数生成相应的日志。

Python 是如何进行类型转换的?

内建函数封装了各种转换函数,可以使用目标类型关键字强制类型转换,进制之间的转换可以用int(‘str’, base=’n’)将特定进制的字符串转换为十进制,再用相应的进制转换函数将十进制转换为目标进制。

可以使用内置函数直接转换的有:

| 函数 | 描述 |

|---|---|

| int(x [,base]) | 将x转换为一个整数 |

| float(x) | 将x转换到一个浮点数 |

| complex(real [,imag]) | 创建一个复数 |

| str(x) | 将对象 x 转换为字符串 |

| repr(x) | 将对象 x 转换为表达式字符串 |

| eval(str) | 用来计算在字符串中的有效Python表达式,并返回一个对象 |

| tuple(s) | 将序列 s 转换为一个元组 |

| list(s) | 将序列 s 转换为一个列表 |

| set(s) | 转换为可变集合 |

| dict(d) | 创建一个字典。d 必须是一个 (key, value)元组序列。 |

| frozenset(s) | 转换为不可变集合 |

| chr(x) | 将一个整数转换为一个字符 |

| ord(x) | 将一个字符转换为它的整数值 |

| hex(x) | 将一个整数转换为一个十六进制字符串 |

| oct(x) | 将一个整数转换为一个八进制字符串 |

Python2 与 Python3 的区别?

-

核心类差异

-

Python3 对 Unicode 字符的原生支持。

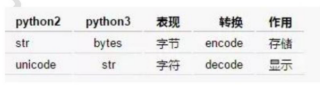

Python2 中使用 ASCII 码作为默认编码方式导致 string 有两种类型 str 和 unicode,Python3 只支持 unicode 的 string。Python2 和 Python3 字节和字符对应关系为:

-

Python3 采用的是绝对路径的方式进行 import。

Python2 中相对路径的 import 会导致标准库导入变得困难(想象一下,同一目录下有 file.py,如何同时导入这个文件和标准库 file)。Python3 中这一点将被修改,如果还需要导入同一目录的文件必须使用绝对路径,否则只能使用相关导入的方式来进行导入。

-

Python2中存在老式类和新式类的区别,Python3统一采用新式类。新式类声明要求继承 object,必须用新式类应用多重继承。

-

Python3 使用更加严格的缩进。Python2 的缩进机制中,1 个 tab 和 8 个 space 是等价的,所

以在缩进中可以同时允许 tab 和 space 在代码中共存。这种等价机制会导致部分 IDE 使用存在问题。Python3 中 1 个 tab 只能找另外一个 tab 替代,因此 tab 和 space 共存会导致报错:TabError:inconsistent use of tabs and spaces in indentation.

Python2 中使用 ASCII 码作为默认编码方式导致 string 有两种类型 str 和 unicode,Python3 只

支持 unicode 的 string。Python2 和 Python3 字节和字符对应关系为:

-

-

废弃类差异

- print 语句被 Python3 废弃,统一使用 print 函数

- exec 语句被 python3 废弃,统一使用 exec 函数

- execfile 语句被 Python3 废弃,推荐使用 exec(open("./filename").read())

- 不相等操作符"<>"被 Python3 废弃,统一使用"!="

- xrange 函数被 Python3 废弃,统一使用 range,Python3 中 range 的机制也进行修改并提高了大数据集生成效率

- Python3 中这些方法再不再返回 list 对象:dictionary 关联的 keys()、values()、items(),zip(),map(),filter(),但是可以通过 list 强行转换:

1. mydict={"a":1,"b":2,"c":3} 2. mydict.keys() #<built-in method keys of dict object at 0x000000000040B4C8> 3. list(mydict.keys()) #['a', 'c', 'b']- 迭代器 iterator 的 next()函数被 Python3 废弃,统一使用 next(iterator)

- raw_input 函数被 Python3 废弃,统一使用 input 函数

- 字典变量的 has_key 函数被Python废弃,统一使用 in 关键词

- file 函数被 Python3 废弃,统一使用 open 来处理文件,可以通过 io.IOBase 检查文件类型

- apply 函数被 Python3 废弃

- 异常 StandardError 被 Python3 废弃,统一使用 Exception

-

修改类差异

-

浮点数除法操作符“/”和“//”的区别

-

“ / ”:

Python2:若为两个整形数进行运算,结果为整形,但若两个数中有一个为浮点数,则结果为浮点数;

Python3:为真除法,运算结果不再根据参加运算的数的类型。

-

“//”:

Python2:返回小于除法运算结果的最大整数;从类型上讲,与"/"运算符返回类型逻辑一致。

Python3:和 Python2 运算结果一样。

-

-

异常抛出和捕捉机制区别

Python2:

1. raise IOError, "file error" #抛出异常 2. except NameError, err: #捕捉异常Python3

1. raise IOError("file error") #抛出异常 2. except NameError as err: #捕捉异常 -

for 循环中变量值区别

Python2,for 循环会修改外部相同名称变量的值

1. i = 1 2. print ('comprehension: ', [i for i in range(5)]) 3. print ('after: i =', i ) #i=4Python3,for 循环不会修改外部相同名称变量的值

1. i = 1 2. print ('comprehension: ', [i for i in range(5)]) 3. print ('after: i =', i ) #i=1 -

round 函数返回值区别

Python2,round 函数返回 float 类型值

1. isinstance(round(15.5),int) #TruePython3,round 函数返回 int 类型值

1. isinstance(round(15.5),float) #True -

比较操作符区别

Python2 中任意两个对象都可以比较

1. ll < 'test' #TruePython3 中只有同一数据类型的对象可以比较

1. ll < 'test' # TypeError: unorderable types: int() < str()

-

-

第三方工具包差异

我们在 pip 官方下载源 pypi 搜索 Python2.7 和 Python3.5 的第三方工具包数可以发现,Python2.7版本对应的第三方工具类目数量是 28523,Python3.5 版本的数量是 12457,这两个版本在第三方工具包支持数量差距相当大。

我们从数据分析的应用角度列举了常见实用的第三方工具包(如下表),并分析这些工具包在Python2.7 和 Python3.5 的支持情况:

| 分类 | 工具名 | 用途 |

|---|---|---|

| 数据收集 | scrapy | 网页采集,爬虫 |

| 数据收集 | scrapy-redis | 分布式爬虫 |

| 数据收集 | selenium | web 测试,仿真浏览器 |

| 数据处理 | beautifulsoup | 网页解释库,提供 lxml 的支持 |

| 数据处理 | lxml | xml 解释库 |

| 数据处理 | xlrd | excel 文件读取 |

| 数据处理 | xlwt | excel 文件写入 |

| 数据处理 | xlutils | excel 文件简单格式修改 |

| 数据处理 | pywin32 | excel 文件的读取写入及复杂格式定制 |

| 数据处理 | Python-docx | Word 文件的读取写入 |

| 数据分析 | numpy | 基于矩阵的数学计算库 |

| 数据分析 | pandas | 基于表格的统计分析库 |

| 数据分析 | scipy | 科学计算库,支持高阶抽象和复杂模型 |

| 数据分析 | statsmodels | 统计建模和计量经济学工具包 |

| 数据分析 | scikit-learn | 机器学习工具库 |

| 数据分析 | gensim | 自然语言处理工具库 |

| 数据分析 | jieba | 中文分词工具库 |

| 数据存储 | MySQL-python | mysql 的读写接口库 |

| 数据存储 | mysqlclient | mysql 的读写接口库 |

| 数据存储 | SQLAlchemy | 数据库的 ORM 封装 |

| 数据存储 | pymssql | sql server 读写接口库 |

| 数据存储 | redis | redis 的读写接口 |

| 数据存储 | PyMongo | mongodb 的读写接口 |

| 数据呈现 | matplotlib | 流行的数据可视化库 |

| 数据呈现 | seaborn | 美观的数据可是湖库,基于 matplotlib |

| 工具辅助 | jupyter | 基于 web 的 python IDE,常用于数据分析 |

| 工具辅助 | chardet | 字符检查工具 |

| 工具辅助 | ConfigParser | 配置文件读写支持 |

| 工具辅助 | requests | HTTP 库,用于网络访问 |

- 工具安装问题

-

windows 环境

Python2 无法安装 mysqlclient。Python3 无法安装 MySQL-python、flup、functools32、Gooey、Pywin32、 webencodings。

matplotlib 在 python3 环境中安装报错:The following required packages can not be built:freetype, png。需要手动下载安装源码包安装解决。

scipy 在 Python3 环境中安装报错,numpy.distutils.system_info.NotFoundError,需要自己手工下载对应的安装包,依赖 numpy,pandas 必须严格根据 python 版本、操作系统、64 位与否。运行matplotlib 后发现基础包 numpy+mkl 安装失败,需要自己下载,国内暂无下载源

-

centos 环境

Python2 无法安装 mysql-python 和 mysqlclient 包,报错:EnvironmentError: mysql_config not found,解决方案是安装 mysql-devel 包解决。使用 matplotlib 报错:no module named _tkinter,安装 Tkinter、tk-devel、tc-devel 解决。

pywin32 也无法在 centos 环境下安装。

-

关于 Python 程序的运行方面,有什么手段能提升性能?

- 使用多进程,充分利用机器的多核性能

- 对于性能影响较大的部分代码,可以使用 C 或 C++编写

- 对于 IO 阻塞造成的性能影响,可以使用 IO 多路复用来解决

- 尽量使用 Python 的内建函数

- 尽量使用局部变量

你所遵循的代码规范是什么?请举例说明其要求?

PEP8 规范。

-

变量

-

常量:大写加下划线 USER_CONSTANT。

-

私有变量 : 小写和一个前导下划线 _private_value。

Python 中不存在私有变量一说,若是遇到需要保护的变量,使用小写和一个前导下划线。但这只是程序员之间的一个约定,用于警告说明这是一个私有变量,外部类不要去访问它。但实际上,外部类还是可以访问到这个变量。

-

内置变量 : 小写,两个前导下划线和两个后置下划线 _class_。

两个前导下划线会导致变量在解释期间被更名。这是为了避免内置变量和其他变量产生冲突。用户定义的变量要严格避免这种风格。以免导致混乱。

-

-

函数和方法

总体而言应该使用小写和下划线。但有些比较老的库使用的是混合大小写,即首单词小写,之后每个单词第一个字母大写,其余小写。但现在,小写和下划线已成为规范。

-

私有方法 :小写和一个前导下划线。

这里和私有变量一样,并不是真正的私有访问权限。同时也应该注意一般函数不要使用两个前导下划线(当遇到两个前导下划线时,Python 的名称改编特性将发挥作用)。

-

特殊方法 :小写和两个前导下划线,两个后置下划线。

这种风格只应用于特殊函数,比如操作符重载等。

-

函数参数 : 小写和下划线,缺省值等号两边无空格

-

-

类

类总是使用驼峰格式命名,即所有单词首字母大写其余字母小写。类名应该简明,精确,并足以从中理解类所完成的工作。常见的一个方法是使用表示其类型或者特性的后缀,例如:SQLEngine,MimeTypes 对于基类而言,可以使用一个 Base 或者 Abstract 前缀 BaseCookie,AbstractGroup。

-

模块和包

除特殊模块 _init_ 之外,模块名称都使用不带下划线的小写字母。

若是它们实现一个协议,那么通常使用 lib 为后缀,例如:import smtplib; import os; import sys

-

关于参数

-

不要用断言来实现静态类型检测。断言可以用于检查参数,但不应仅仅是进行静态类型检测。Python 是动态类型语言,静态类型检测违背了其设计思想。断言应该用于避免函数不被毫无意义的调用。

-

不要滥用 args 和 **kwargs。args 和 **kwargs 参数可能会破坏函数的健壮性。它们使签名变得模糊,而且代码常常开始在不应该的地方构建小的参数解析器。

-

其他

-

使用 has 或 is 前缀命名布尔元素

例如:is_connect = True,has_member = False

-

用复数形式命名序列

例如:members = ['user_1', 'user_2']

-

用显式名称命名字典

例如:person_address =

-

避免通用名称

诸如 list, dict, sequence 或者 element 这样的名称应该避免。

-

避免现有名称

诸如 os, sys 这种系统已经存在的名称应该避免。

-

-

一些数字

- 一行列数 : PEP 8 规定为 79 列。根据自己的情况,比如不要超过满屏时编辑器的显示列数。

- 一个函数 : 不要超过 30 行代码, 即可显示在一个屏幕类,可以不使用垂直游标即可看到整个函数。

- 一个类 : 不要超过 200 行代码,不要有超过 10 个方法。一个模块 不要超过 500 行。

-

验证脚本

可以安装一个 pep8 脚本用于验证你的代码风格是否符合 PEP8。

https://www.liaoxuefeng.com/wiki/896043488029600/900004111093344

dumps,loads 与 dump,load 的区别?

- json.dumps()将 pyhton 的 dict 数据类型编码为 json 字符串;

- json.loads()将 json 字符串解码为 dict 的数据类型;

- json.dump(x,y) x 是 json 对象, y 是文件对象,最终是将 json 对象写入到文件中;

- json.load(y) 从文件对象 y 中读取 json 对象。

什么是可变、不可变类型?

可变不可变指的是内存中的值是否可以被改变,不可变类型指的是对象所在内存块里面的值不可以

改变,有数值、字符串、元组;可变类型则是可以改变,主要有列表、字典、集合。

- 不可变数据(3 个):Number(数字)、String(字符串)、Tuple(元组);

- 可变数据(3 个):List(列表)、Dictionary(字典)、Set(集合)。

更多详见:

Python3 基本数据类型

Python 主要的内置数据类型都有哪些? print dir( ‘a ’) 的输出?

内建类型:布尔类型、数字、字符串、列表、元组、字典、集合;

输出字符串‘a’的内建方法;

Python 中 is 和==的区别?

is 判断的是 a 对象是否就是 b 对象,是通过 id 来判断的。

==判断的是 a 对象的值是否和 b 对象的值相等,是通过 value 来判断的。

字典

dict:字典,字典是一组键(key)和值(value)的组合,通过键(key)进行查找,没有顺序, 使用大括号”{}”;

应用场景:

dict使用键和值进行关联的数据;

现有字典 d={‘a’:24,‘g’:52,‘i’:12,‘k’:33}请按字典中的 value值进行排序?

sorted(d.items(),key = lambda x:x[1])

说一下字典和 json 的区别?

字典是一种数据结构,json 是一种数据的表现形式,字典的 key 值只要是能 hash 的就行,json 的键必须是字符串。

存入字典里的数据有没有先后排序?

存入的数据不会自动排序,可以使用 sort 函数对字典进行排序。

字典推导式?

d = {key: value for (key, value) in iterable}

现有字典 d={‘a’:24,’g’:52,’l’:12,’k’:33}请按字典中的value值进行排序?

sorted(d.items(),key = lambda x:x[1])

更多字典相关内容详见:

Python3 字典

字符串

str:字符串是 Python 中最常用的数据类型。我们可以使用引号'或"来创建字符串。

如何理解 Python 中字符串中的\字符?

有三种不同的含义:1、转义字符;2、路径名中用来连接路径名;3、编写太长代码手动软换行。

请反转字符串“aStr”?

方法一:

print(‘aStr’[::-1])

方法二:

''.join(reversed(‘aStr’))

将字符串"k:1|k1:2|k2:3|k3:4",处理成 Python 字典:{k:1, k1:2, ... } # 字典里的 K 作为字符串处理

1. str1 = "k:1|k1:2|k2:3|k3:4"

2. def str2dict(str1):

3. dict1 = {}

4. for iterms in str1.split('|'):

5. key,value = iterms.split(':')

6. dict1[key] = value

7. return dict1

更多字典字符串相关内容详见:

Python3 字符串

列表

list:是 Python 中使用最频繁的数据类型,在其他语言中通常叫做数组,通过索引进行查找,使用方括号”[]”,列表是有序的集合。

应用场景:定义列表使用 [ ] 定义,数据之间使用 “,”分割。

列表的索引从 0 开始:索引就是数据在列表中的位置编号,索引又可以被称为下标

【注意】: 从列表中取值时,如果超出索引范围,程序会产生异常。

IndexError: list index out of range

列表的常用操作:

| 序号 | 方法 |

|---|---|

| 1 | list.append(obj) 在列表末尾添加新的对象 |

| 2 | list.count(obj) 统计某个元素在列表中出现的次数 |

| 3 | list.extend(seq) 在列表末尾一次性追加另一个序列中的多个值(用新列表扩展原来的列表) |

| 4 | list.index(obj) 从列表中找出某个值第一个匹配项的索引位置 |

| 5 | list.insert(index, obj) 将对象插入列表 |

| 6 | list.pop([index=-1]) 移除列表中的一个元素(默认最后一个元素),并且返回该元素的值 |

| 7 | list.remove(obj) 移除列表中某个值的第一个匹配项 |

| 8 | list.reverse() 反向列表中元素 |

| 9 | list.sort( key=None, reverse=False) 对原列表进行排序 |

| 10 | list.clear() 清空列表 |

| 11 | list.copy() 复制列表 |

| 14 | del list[index] 删除指定索引的数据 |

| 15 | max(list) 返回列表元素最大值 |

| 16 | min(list) 返回列表元素最小值 |

| 17 | len(list) 列表元素个数 |

| 18 | in 判断列表中是否包含某元素 |

请按 alist 中元素的 age 由大到小排序

1. alist = [{'name':'a','age':20},{'name':'b','age':30},{'name':'c','age':25}]

2. def sort_by_age(list1):

3. return sorted(alist,key=lambda x:x['age'],reverse=True)

下面代码的输出结果将是什么?

1. list = ['a', 'b', 'c', 'd', 'e']

2. print list[10:]

下面的代码将输出[],不会产生IndexError错误。就像所期望的那样,尝试用超出成员的个数的index来获取某个列表的成员。例如,尝试获取 list[10]和之后的成员,会导致 IndexError。然而,尝试获取列表的切片,开始的 index 超过了成员个数不会产生 IndexError,而是仅仅返回一个空列表。这成为特别让人恶心的疑难杂症,因为运行的时候没有错误产生,导致 bug 很难被追踪到。

写一个列表生成式,产生一个公差为 11 的等差数列

1. print([x*11 for x in range(10)])

给定两个列表,怎么找出他们相同的元素和不同的元素?

1. list1 = [1,2,3]

2. list2 = [3,4,5]

3. set1 = set(list1)

4. set2 = set(list2)

5. print(set1&set2)

6. print(set1^set2)

请写出一段 Python 代码实现删除一个 list 里面的重复元素?

方法一:

1. l1 = ['b','c','d','b','c','a','a']

2. l2 = list(set(l1))

3. print(l2)

如果想要保持他们原来的排序:

方法一:

1. l1 = ['b','c','d','b','c','a','a']

2. l2 = list(set(l1))

3. l2.sort(key=l1.index)

4. print(l2)

方法二:

1. l1 = ['b','c','d','b','c','a','a']

2. l2 = sorted(set(l1),key=l1.index)

3. print(l2)

方法三:

1. l1 = ['b', 'c', 'd', 'b', 'c', 'a', 'a']

2. l2 = []

3. for i in l1:

4. if not i in l2:

5. l2.append(i)

6. print(l2)

有如下数组 list = range(10)我想取以下几个数组,应该如何切片?

1. [1,2,3,4,5,6,7,8,9]

2. [1,2,3,4,5,6]

3. [3,4,5,6]

4. [9]

5. [1,3,5,7,9]

答:

1. [1:]

2. [1:7]

3. [3:7]

4. [-1]

5. [1::2]

下面这段代码的输出结果是什么?请解释?

1. def extendlist(val, list=[]):

2. list.append(val)

3. return list

4.

5. list1 = extendlist(10)

6. list2 = extendlist(123, [])

7. list3 = extendlist('a')

8.

9. print("list1 = %s" %list1)

10. print("list2 = %s" %list2)

11. print("list3 = %s" %list3)

输出结果:

list1 = [10, 'a']

list2 = [123]

list3 = [10, 'a']

新的默认列表只在函数被定义的那一刻创建一次。当 extendList 被没有指定特定参数 list 调用时,这组 list 的值随后将被使用。这是因为带有默认参数的表达式在函数被定义的时候被计算,不是在调用的时候被计算。

将以下 3 个函数按照执行效率高低排序

1. def f1(lIn):

2. l1 = sorted(lIn)

3. l2 = [i for i in l1 if i<0.5]

4. return [i*i for i in l2]

5.

6.

7. def f2(lIn):

8. l1 = [i for i in l1 if i<0.5]

9. l2 = sorted(l1)

10. return [i*i for i in l2]

11.

12.

13. def f3(lIn):

14. l1 = [i*i for i in lIn]

15. l2 = sorted(l1)

16. return [i for i in l1 if i<(0.5*0.5)]

按执行效率从高到低排列:f2、f1 和 f3。要证明这个答案是正确的,你应该知道如何分析自己代码的性能。Python中有一个很好的程序分析包,可以满足这个需求。

1. import random

2. import cProfile

3. lIn = [random.random() for i in range(100000)]

4. cProfile.run('f1(lIn)')

5. cProfile.run('f2(lIn)')

6. cProfile.run('f3(lIn)')

获取 1~100 被 6 整除的偶数?

1. def A():

2. alist = []

3. for i in range(1,100):

4. if i % 6 == 0:

5. alist.append(i)

6. last_num = alist[-3:]

7. print(last_num)

更多列表相关内容详见:

Python3 列表

元组

tuple:元组,元组将多样的对象集合到一起,不能修改,通过索引进行查找,使用括号”()”;

应用场景:把一些数据当做一个整体去使用,不能修改;

更多元组相关内容详见:

Python3 元组

集合

set:set 集合,在 Python 中的书写方式为{},集合与之前列表、元组类似,可以存储多个数据,但是这些数据是不重复的。集合对象还支持 union(联合), intersection(交), difference(差)和sysmmetric_difference(对称差集)等数学运算.

| 运算符 | 含义 |

|---|---|

| a&b | 交集:共有的部分 |

| a|b | 并集:总共的部分 |

| b - a | 差集:另一个集合中没有的部分 |

| a ^ b | 对称差集(在 a 或 b 中,但不会同时出现在二者中) |

更多集合相关内容详见:

Python3 集合

二、Python高级

类

_init_ 和 __new__ 的区别?

_init_ 在对象创建后,对对象进行初始化。

__new__ 是在对象创建之前创建一个对象,并将该对象返回给 _init_。

Python 中类方法、类实例方法、静态方法有何区别?

类方法:是类对象的方法,在定义时需要在上方使用“@classmethod”进行装饰,形参为 cls,表示类对象,类对象和实例对象都可调用;

类实例方法:是类实例化对象的方法,只有实例对象可以调用,形参为 self,指代对象本身;

静态方法:是一个任意函数,在其上方使用“@staticmethod”进行装饰,可以用对象直接调用,静态方法实际上跟该类没有太大关系。

Python 中的可变对象和不可变对象?

不可变对象:该对象所指向的内存中的值不能被改变。当改变某个变量时候,由于其所指的值不能被改变,相当于把原来的值复制一份后再改变,这会开辟一个新的地址,变量再指向这个新的地址。

可变对象:该对象所指向的内存中的值可以被改变。变量(准确的说是引用)改变后,实际上是其所指的值直接发生改变,并没有发生复制行为,也没有开辟新的出地址,通俗点说就是原地改变。

Python 中,数值类型(int 和 float)、字符串 str、元组 tuple 都是不可变类型。而列表 list、字典 dict、集合set 是可变类型。

Python 的魔法方法

魔法方法就是可以给你的类增加魔力的特殊方法,如果你的对象实现 (重载)了这些方法中的某一个,那么这个方法就会在特殊的情况下被 Python 所调用,你可以定义自己想要的行为,而这一切都是自动发生的。 它们经常是两个下划线包围来命名的(比如 _init__,__lt_),Python 的魔法方法是非常强大的,所以了解其使用方法也变得尤为重要!

- _init_ 构造器,当一个实例被创建的时候初始化的方法。但是它并不是实例化调用的第一个方法。

- __new__才是实例化对象调用的第一个方法,它只取下 cls 参数,并把其他参数传给 __init__。 __new__很少使用,但是也有它适合的场景,尤其 是当类继承自一个像元组或者字符串这样不经常改变的类型的时候。

- __call__ 允许一个类的实例像函数一样被调用 。

- __getitem__ 定义获取容器中指定元素的行为,相当于 self[key] 。

- __getattr__ 定义当用户试图访问一个不存在属性的时候的行为 。

- __setattr__ 定义当一个属性被设置的时候的行为 。

- __getattribute__ 定义当一个属性被访问的时候的行为 。

面向对象中怎么实现只读属性?

将对象私有化,通过共有方法提供一个读取数据的接口。

1.class person:

2. def __init__(self,x):

3. self.__age = 10;

4. def age(self):

5. return self.__age;

6.t = person(22)

7.# t.__age = 100

8.print(t.age())

最好的方法

1.class MyCls(object):

2. __weight = 50

3.

4. @property #以访问属性的方式来访问 weight 方法

5. def weight(self):

6. return self.__weight

7.

8.if __name__ == '__main__':

9. obj = MyCls()

10. print(obj.weight)

11. obj.weight = 12

1.Traceback (most recent call last):

2.50

3. File "C:/PythonTest/test.py", line 11, in <module>

4. obj.weight = 12

5.AttributeError: can't set attribute

谈谈你对面向对象的理解?

面向对象是相对于面向过程而言的。面向过程语言是一种基于功能分析的、以算法为中心的程序设计方法;而面向对象是一种基于结构分析的、以数据为中心的程序设计思想。在面向对象语言中有一个有很重要东西,叫做类。

面向对象有三大特性:封装、继承、多态。

更多面向对象相关内容详见:

Python3 面向对象

Python 中如何动态获取和设置对象的属性?

1. if hasattr(Parent,'x'):

2. print(getattr(Parent,'x'))

3. setattr(Parent,'x',3)

4. print(getattr(Parent,'x'))

内存管理与垃圾回收机制

Python 的内存管理机制及调优手段?

内存管理机制:引用计数、垃圾回收、内存池。

引用计数:引用计数是一种非常高效的内存管理手段, 当一个 Python 对象被引用时其引用计数增加 1, 当其不再被一个变量引用时则计数减 1。当引用计数等于 0 时,对象被删除。

垃圾回收 :

-

引用计数:引用计数也是一种垃圾收集机制,而且也是一种最直观,最简单的垃圾收集技术。当 Python 的某个对象的引用计数降为 0 时,说明没有任何引用指向该对象,该对象就成为要被回收的垃圾了。比如某个新建对象,它被分配给某个引用,对象的引用计数变为 1。如果引用被删除,对象的引用计数为 0,那么该对象就可以被垃圾回收。不过如果出现循环引用的话,引用计数机制就不再起有效的作用了。

-

标记清除:如果两个对象的引用计数都为 1,但是仅仅存在他们之间的循环引用,那么这两个对象都是需要被回收的,也就是说,它们的引用计数虽然表现为非 0,但实际上有效的引用计数为 0。所以先将循环引用摘掉,就会得出这两个对象的有效计数。

-

分代回收:从前面“标记-清除”这样的垃圾收集机制来看,这种垃圾收集机制所带来的额外操作实际上与系统中总的内存块的数量是相关的,当需要回收的内存块越多时,垃圾检测带来的额外操作就越多,而垃圾回收带来的额外操作就越少;反之,当需回收的内存块越少时,垃圾检测就将比垃圾回收带来更少的额外操作。

举个例子:

当某些内存块 M 经过了 3 次垃圾收集的清洗之后还存活时,我们就将内存块 M 划到一个集合A 中去,而新分配的内存都划分到集合 B 中去。当垃圾收集开始工作时,大多数情况都只对集合 B 进行垃圾回收,而对集合 A 进行垃圾回收要隔相当长一段时间后才进行,这就使得垃圾收集机制需要处理的内存少了,效率自然就提高了。在这个过程中,集合 B 中的某些内存块由于存活时间长而会被转移到集合 A 中,当然,集合 A 中实际上也存在一些垃圾,这些垃圾的回收会因为这种分代的机制而被延迟。

内存池:

- Python 的内存机制呈现金字塔形状,-1,-2 层主要有操作系统进行操作;

- 第 0 层是 C 中的 malloc,free 等内存分配和释放函数进行操作;

- 第 1 层和第 2 层是内存池,有 Python 的接口函数 PyMem_Malloc 函数实现,当对象小于256K 时有该层直接分配内存;

- 第 3 层是最上层,也就是我们对 Python 对象的直接操作

Python 在运行期间会大量地执行 malloc 和 free 的操作,频繁地在用户态和核心态之间进行切换,这将严重影响 Python 的执行效率。为了加速 Python 的执行效率,Python 引入了一个内存池机制,用于管理对小块内存的申请和释放。

Python 内部默认的小块内存与大块内存的分界点定在 256 个字节,当申请的内存小于 256 字节时,PyObject_Malloc 会在内存池中申请内存;当申请的内存大于 256 字节时,PyObject_Malloc 的行为将蜕化为 malloc 的行为。当然,通过修改 Python 源代码,我们可以改变这个默认值,从而改变 Python 的默认内存管理行为。

调优手段:

- 手动垃圾回收

- 调高垃圾回收阈值

- 避免循环引用(手动解循环引用和使用弱引用)

内存泄露是什么?如何避免?

指由于疏忽或错误造成程序未能释放已经不再使用的内存的情况。内存泄漏并非指内存在物理上的消失,而是应用程序分配某段内存后,由于设计错误,失去了对该段内存的控制,因而造成了内存的浪费。导致程序运行速度减慢甚至系统崩溃等严重后果。

有 _del_() 函数的对象间的循环引用是导致内存泄漏的主凶。

避免方式:

- 不使用一个对象时使用:del object 来删除一个对象的引用计数就可以有效防止内存泄漏问题。

- 通过 Python 扩展模块 gc 来查看不能回收的对象的详细信息。

- 可以通过 sys.getrefcount(obj) 来获取对象的引用计数,并根据返回值是否为 0 来判断是否内存泄漏。

函数

Python 函数调用的时候参数的传递方式是值传递还是引用传递?

Python 的参数传递有:位置参数、默认参数、可变参数、关键字参数。

函数的传值到底是值传递还是引用传递,要分情况:

- 不可变参数用值传递:像整数和字符串这样的不可变对象,是通过拷贝进行传递的,因为你无论如何都不可能在原处改变不可变对象

- 可变参数是引用传递的:比如像列表,字典这样的对象是通过引用传递、和 C 语言里面的用指针传递数组很相似,可变对象能在函数内部改变。

对缺省参数的理解?

缺省参数指在调用函数的时候没有传入参数的情况下,调用默认的参数,在调用函数的同时赋值时,所传入的参数会替代默认参数。

*args 是不定长参数,他可以表示输入参数是不确定的,可以是任意多个。

**kwargs 是关键字参数,赋值的时候是以键 = 值的方式,参数是可以任意多对在定义函数的时候不确定会有多少参数会传入时,就可以使用两个参数。

为什么函数名字可以当做参数用?

Python 中一切皆对象,函数名是函数在内存中的空间,也是一个对象。

Python 中 pass 语句的作用是什么?

在编写代码时只写框架思路,具体实现还未编写就可以用 pass 进行占位,使程序不报错,不会进行任何操作。

有这样一段代码,print(c)会输出什么,为什么?

1. a = 10

2. b = 20

3. c = [a]

4. a = 15

答:10 。对于字符串、数字,传递是相应的值。

更多函数相关内容详见:

Python3 函数

内建函数

map 函数?

从参数方面来讲:map()包含两个参数,第一个参数是一个函数,第二个是序列(列表 或元组)。其中,函数(即 map的第一个参数位置的函数)可以接收一个或多个参数。

从对传进去的数值作用来讲:map()是将传入的函数依次作用到序列的每个元素,每个元素都是独自被函数“作用”一次 。

更多内置函数相关内容详见:

Python3 内置函数

递归函数停止的条件?

递归的终止条件一般定义在递归函数内部,在递归调用前要做一个条件判断,根据判断的结果选择是继续调用自身,还是 return返回终止递归。

终止的条件:

-

判断递归的次数是否达到某一限定值

-

判断运算的结果是否达到某个范围等,根据设计的目的来选择

回调函数是如何通信的?

回调函数是把函数的地址作为参数传递给另一个函数,将整个函数当作一个对象,赋值给调用的函数。

hasattr() getattr() setattr() 函数使用详解?

hasattr(object, name)函数:判断一个对象里面是否有name属性或者name方法,返回bool值,有name属性(方法)返回True,否则返回 False。

注意:name 要使用引号括起来。

1. class function_demo(object):

2. name = 'demo'

3. def run(self):

4. return "hello function"

5. functiondemo = function_demo()

6. res = hasattr(functiondemo, 'name') #判断对象是否有 name 属性,True

7. res = hasattr(functiondemo, "run") #判断对象是否有 run 方法,True

8. res = hasattr(functiondemo, "age") #判断对象是否有 age 属性,Falsw

9. print(res)

getattr(object, name[,default]) 函数:获取对象 object 的属性或者方法,如果存在则打印出来,如果不存在,打印默认值,默认值可选。

注意:如果返回的是对象的方法,则打印结果是:方法的内存地址,如果需要运行这个方法,可以在后面添加括号()。

1. functiondemo = function_demo()

2. getattr(functiondemo, 'name') #获取 name 属性,存在就打印出来--- demo

3. getattr(functiondemo, "run") #获取 run 方法,存在打印出 方法的内存地址---<bound method function_demo.run of <__main__.function_demo object at 0x10244f320>>

4. getattr(functiondemo, "age") #获取不存在的属性,报错如下:

5. Traceback (most recent call last):

6. File "/Users/liuhuiling/Desktop/MT_code/OpAPIDemo/conf/OPCommUtil.py", line 39, in <module>

7. res = getattr(functiondemo, "age")

8. AttributeError: 'function_demo' object has no attribute 'age'

9. getattr(functiondemo, "age", 18) #获取不存在的属性,返回一个默认值

setattr(object,name,values)函数:给对象的属性赋值,若属性不存在,先创建再赋值

1.class function_demo(object):

2. name = 'demo'

3. def run(self):

4. return "hello function"

5.functiondemo = function_demo()

6.res = hasattr(functiondemo, 'age') # 判断 age 属性是否存在,False

7.print(res)

8.setattr(functiondemo, 'age', 18 ) #对 age 属性进行赋值,无返回值

9.res1 = hasattr(functiondemo, 'age') #再次判断属性是否存在,True

综合使用:

1.class function_demo(object):

2. name = 'demo'

3. def run(self):

4. return "hello function"

5.functiondemo = function_demo()

6.res = hasattr(functiondemo, 'addr') # 先判断是否存在 if res:

7. addr = getattr(functiondemo, 'addr')

8. print(addr)else:

9. addr = getattr(functiondemo, 'addr', setattr(functiondemo, 'addr', '北京首都'))

10. #addr = getattr(functiondemo, 'addr', '美国纽约')

11. print(addr)

Lambda

什么是 lambda 函数? 有什么好处?

lambda 函数是一个可以接收任意多个参数(包括可选参数)并且返回单个表达式值的函数

- lambda 函数比较轻便,即用即仍,很适合需要完成一项功能,但是此功能只在此一处使用,连名字都很随意的情况下;

- 匿名函数,一般用来给 filter, map 这样的函数式编程服务;

- 作为回调函数,传递给某些应用,比如消息处理

下面这段代码的输出结果将是什么?请解释。

1. def multipliers():

2. return [lambda x : i * x for i in range(4)]

3. print [m(2) for m in multipliers()]

上面代码输出的结果是[6, 6, 6, 6] (不是我们想的[0, 2, 4, 6])。

你如何修改上面的 multipliers 的定义产生想要的结果?

上述问题产生的原因是 Python 闭包的延迟绑定。这意味着内部函数被调用时,参数的值在闭包内进行查找。因此,当任何由 multipliers()返回的函数被调用时,i 的值将在附近的范围进行查找。那时,不管返回的函数是否被调用,for 循环已经完成,i 被赋予了最终的值 3。

因此,每次返回的函数乘以传递过来的值 3,因为上段代码传过来的值是 2,它们最终返回的都是 6。(3*2)碰巧的是,《The Hitchhiker’s Guide to Python》也指出,在与 lambdas 函数相关也有一个被广泛被误解的知识点,不过跟这个 case 不一样。由 lambda 表达式创造的函数没有什么特殊的地方,它其实是和 def 创造的函数式一的。下面是解决这一问题的一些方法。

方法一:使用Python生成器。

1. def multipliers():

2. for i in range(4): yield lambda x : i * x

方法二:创造一个闭包,利用默认函数立即绑定。

1. def multipliers():

2. return [lambda x, i=i : i * x for i in range(4)]

设计模式

请手写一个单例

1. class A(object):

2. __instance = None

3. def __new__(cls, *args, **kwargs):

4. if cls.__instance is None:

5. cls.__instance = object.__new__(cls)

6. return cls.__instance

7. else:

8. return cls.__instance

单例模式的应用场景有哪些?

单例模式应用的场景一般发现在以下条件下:

- 资源共享的情况下,避免由于资源操作时导致的性能或损耗等。如日志文件,应用配置。

- 控制资源的情况下,方便资源之间的互相通信。如线程池等。 1.网站的计数器 2.应用配置 3.多线程池 4.数据库配置,数据库连接池 5.应用程序的日志应用....

工厂模式

class Person:

def __init__(self):

self.name = None

self.gender = None

def getName(self):

return self.name

def getGender(self):

return self.gender

class Male(Person):

def __init__(self, name):

print("Hello Mr." + name)

class Female(Person):

def __init__(self, name):

print("Hello Miss." + name)

class Factory:

def getPerson(self, name, gender):

if gender == 'M':

return Male(name)

if gender == 'F':

return Female(name)

if __name__ == '__main__':

factory = Factory()

person = factory.getPerson("Chetan", "M")

对装饰器的理解 ,并写出一个计时器记录方法执行性能的装饰器?

装饰器本质上是一个 Python 函数,它可以在让其他函数在不需要做任何代码的变动的前提下增加额外的功能。装饰器的返回值也是一个函数的对象,它经常用于有切面需求的场景。 比如:插入日志、性能测试、事务处理、缓存、权限的校验等场景 有了装饰器就可以抽离出大量的与函数功能本身无关的雷同代码并发并继续使用。

1. import time

2. def timeit(func):

3. def wrapper():

4. start = time.clock()

5. func()

6. end =time.clock()

7. print('used:', end - start)

8. return wrapper

9. @timeit

10. def foo():

11. print('in foo()')

12. foo()

解释一下什么是闭包?

在函数内部再定义一个函数,并且这个函数用到了外边函数的变量,那么将这个函数以及用到的一些变量称之为闭包。

生成器、迭代器的区别?

迭代器是一个更抽象的概念,任何对象,如果它的类有 next 方法和 iter 方法返回自己本身,对于 string、list、dict、tuple 等这类容器对象,使用 for 循环遍历是很方便的。在后台 for 语句对容器对象调用 iter()函数,iter()是 python 的内置函数。iter()会返回一个定义了 next()方法的迭代器对象,它在容器中逐个访问容器内元素,next()也是 python 的内置函数。在没有后续元素时,next()会抛出一个StopIteration 异常。

生成器(Generator)是创建迭代器的简单而强大的工具。它们写起来就像是正规的函数,只是在需要返回数据的时候使用 yield 语句。每次 next()被调用时,生成器会返回它脱离的位置(它记忆语句最后一次执行的位置和所有的数据值)

区别:生成器能做到迭代器能做的所有事,而且因为自动创建了 iter()和 next()方法,生成器显得特别简洁,而且生成器也是高效的,使用生成器表达式取代列表解析可以同时节省内存。除了创建和保存程序状态的自动方法,当生成器终结时,还会自动抛出 StopIteration 异常。

Python 中 yield 的用法?

yield 就是保存当前程序执行状态。你用 for 循环的时候,每次取一个元素的时候就会计算一次。用 yield 的函数叫 generator,和 iterator 一样,它的好处是不用一次计算所有元素,而是用一次算一次,可以节省很多空间。generator每次计算需要上一次计算结果,所以用 yield,否则一 return,上次计算结果就没了。

1. >>> def createGenerator():

2. ... mylist = range(3)

3. ... for i in mylist:

4. ... yield i*i

5. ...

6. >>> mygenerator = createGenerator() # create a generator

7. >>> print(mygenerator) # mygenerator is an object!

8. <generator object createGenerator at 0xb7555c34>

9. >>> for i in mygenerator:

10. ... print(i)

11. 0

12. 1

13. 4

请尝试用“一行代码”实现将 1-N 的整数列表以 3 为单位分组,比如 1-100分组后为?

1. print([[x for x in range(1,100)][i:i+3] for i in range(0,len(list_a),3)])

正则表达式

Python 里 match 与 search 的区别?

match()函数只检测 RE 是不是在 string 的开始位置匹配,search()会扫描整个 string 查找匹配;也就是说 match()只有在 0 位置匹配成功的话才有返回,如果不是开始位置匹配成功的话,match()就返回 none。

Python 字符串查找和替换?

1. re.findall(r’目的字符串’,’原有字符串’) #查询

2. re.findall(r'cast','itcast.cn')[0]

3. re.sub(r‘要替换原字符’,’要替换新字符’,’原始字符串’)

4. re.sub(r'cast','heima','itcast.cn')

用 Python 匹配 HTML tag 的时候,<.> 和 <.?> 有什么区别?

<.*>是贪婪匹配,会从第一个“<”开始匹配,直到最后一个“>”中间所有的字符都会匹配到,中间可能会包含“<>”。

<.*?>是非贪婪匹配,从第一个“<”开始往后,遇到第一个“>”结束匹配,这中间的字符串都会匹配到,但是不会有“<>”。

请写出下列正则关键字的含义?

| 模式 | 描述 |

|---|---|

| ^ | 匹配字符串的开头 |

| $ | 匹配字符串的末尾。 |

| . | 匹配任意字符,除了换行符,当re.DOTALL标记被指定时,则可以匹配包括换行符的任意字符。 |

| [...] | 用来表示一组字符,单独列出:[amk] 匹配 'a','m'或'k' |

| [^...] | 不在[]中的字符:[^abc] 匹配除了a,b,c之外的字符。 |

| re* | 匹配0个或多个的表达式。 |

| re+ | 匹配1个或多个的表达式。 |

| re? | 匹配0个或1个由前面的正则表达式定义的片段,非贪婪方式 |

| re | 匹配n个前面表达式。例如,"o{2}"不能匹配"Bob"中的"o",但是能匹配"food"中的两个o。 |

| re | 精确匹配n个前面表达式。例如,"o{2,}"不能匹配"Bob"中的"o",但能匹配"foooood"中的所有o。"o{1,}"等价于"o+"。"o{0,}"则等价于"o*"。 |

| re | 匹配 n 到 m 次由前面的正则表达式定义的片段,贪婪方式 |

| a| b | 匹配a或b |

| (re) | 匹配括号内的表达式,也表示一个组 |

| (?imx) | 正则表达式包含三种可选标志:i, m, 或 x 。只影响括号中的区域。 |

| (?-imx) | 正则表达式关闭 i, m, 或 x 可选标志。只影响括号中的区域。 |

| (?: re) | 类似 (...), 但是不表示一个组 |

| (?imx: re) | 在括号中使用i, m, 或 x 可选标志 |

| (?-imx: re) | 在括号中不使用i, m, 或 x 可选标志 |

| (?#...) | 注释. |

| (?= re) | 前向肯定界定符。如果所含正则表达式,以 ... 表示,在当前位置成功匹配时成功,否则失败。但一旦所含表达式已经尝试,匹配引擎根本没有提高;模式的剩余部分还要尝试界定符的右边。 |

| (?! re) | 前向否定界定符。与肯定界定符相反;当所含表达式不能在字符串当前位置匹配时成功。 |

| (?> re) | 匹配的独立模式,省去回溯。 |

| \w | 匹配数字字母下划线 |

| \W | 匹配非数字字母下划线 |

| \s | 匹配任意空白字符,等价于 [\t\n\r\f]。 |

| \S | 匹配任意非空字符 |

| \d | 匹配任意数字,等价于 [0-9]。 |

| \D | 匹配任意非数字 |

| \A | 匹配字符串开始 |

| \Z | 匹配字符串结束,如果是存在换行,只匹配到换行前的结束字符串。 |

| \z | 匹配字符串结束 |

| \G | 匹配最后匹配完成的位置。 |

| \b | 匹配一个单词边界,也就是指单词和空格间的位置。例如, 'er\b' 可以匹配"never" 中的 'er',但不能匹配 "verb" 中的 'er'。 |

| \B | 匹配非单词边界。'er\B' 能匹配 "verb" 中的 'er',但不能匹配 "never" 中的 'er'。 |

| \n, \t, 等。 | 匹配一个换行符。匹配一个制表符, 等 |

| \1...\9 | 匹配第n个分组的内容。 |

| \10 | 匹配第n个分组的内容,如果它经匹配。否则指的是八进制字符码的表达式。 |

更多正则相关内容详见:

Python3 正则表达式

系统编程

进程、线程和协程

更多相关内容详见:

multiprocessing--- 基于进程的并行

threading--- 基于线程的并行协程与任务

进程:程序运行在操作系统上的一个实例,就称之为进程。进程需要相应的系统资源:内存、时间片、pid。

创建进程步骤

- 首先要导入 multiprocessing 中的 Process;

- 实例化一个 Process 对象并传递参数;

- 使用 start()启动进程;

- 结束进程。

Process 语法结构

Process([group [, target [, name [, args [, kwargs]]]]])

-

target:如果传递了函数的引用,可以让这个子进程就执行函数中的代码

-

args:给 target 指定的函数传递的参数,以元组的形式进行传递

-

kwargs:给 target 指定的函数传递参数,以字典的形式进行传递

-

name:给进程设定一个名字,可以省略

-

group:指定进程组,大多数情况下用不到

Process 创建的实例对象的常用方法有:

-

start():启动子进程实例(创建子进程)

-

is_alive():判断进程子进程是否还在活着

-

join(timeout):是否等待子进程执行结束,或者等待多少秒

-

terminate():不管任务是否完成,立即终止子进程

Process 创建的实例对象的常用属性:

-

name:当前进程的别名,默认为 Process-N,N 为从 1 开始递增的整数

-

pid:当前进程的 pid(进程号)

给子进程指定函数传递参数 Demo

1.import os

2. from multiprocessing import Process

2.import time

3.

4.def pro_func(name, age, **kwargs):

5. for i in range(5):

6. print("子进程正在运行中,name=%s, age=%d, pid=%d" %(name, age, os.getpid()))

7. print(kwargs)

8. time.sleep(0.2)

9.

10.if __name__ == '__main__':

11. # 创建 Process 对象

12. p = Process(target=pro_func, args=('小明',18), kwargs={'m': 20})

13. # 启动进程

14. p.start()

15. time.sleep(1)

16. # 1 秒钟之后,立刻结束子进程

17. p.terminate()

18. p.join()

注意:进程间不共享全局变量。

进程之间的通信-Queue

在初始化Queue()对象时,(例如 q=Queue(),若在括号中没有指定最大可接受的消息数量,或数

量为负值时,那么就代表可接受的消息数量没有上限-直到内存的尽头)

- Queue.qsize():返回当前队列包含的消息数量。

- Queue.empty():如果队列为空,返回 True,反之 False。

- Queue.full():如果队列满了,返回 True,反之 False。

- Queue.get([block[,timeout]]):获取队列中的一条消息,然后将其从队列中移除,block 默认值为True。

- 如果 block 使用默认值,且没有设置 timeout(单位秒),消息列队如果为空,此时程序将被阻塞(停在读取状态),直到从消息列队读到消息为止,如果设置了 timeout,则会等待timeout 秒,若还没读取到任何消息,则抛出"Queue.Empty"异常;

- 如果 block 值为 False,消息列队如果为空,则会立刻抛出"Queue.Empty"异常;

- Queue.get_nowait():相当 Queue.get(False);

- Queue.put(item,[block[, timeout]]):将 item 消息写入队列,block 默认值为 True;

- 如果 block 使用默认值,且没有设置 timeout(单位秒),消息列队如果已经没有空间可写入,此时程序将被阻塞(停在写入状态),直到从消息列队腾出空间为止,如果设置了 timeout,则会等待timeout 秒,若还没空间,则抛出"Queue.Full"异常;

- 如果 block 值为 False,消息列队如果没有空间可写入,则会立刻抛出"Queue.Full"异常;

- Queue.put_nowait(item):相当 Queue.put(item, False);

进程间通信

1.from multiprocessing import Process, Queueimport os, time, random

2.# 写数据进程执行的代码:def write(q):

3. for value in ['A', 'B', 'C']:

4. print('Put %s to queue...' % value)

5. q.put(value)

6. time.sleep(random.random())

7.# 读数据进程执行的代码:def read(q):

8. while True:

9. if not q.empty():

10. value = q.get(True)

11. print('Get %s from queue.' % value)

12. time.sleep(random.random())

13. else:

14. break

15.if __name__=='__main__':

16. # 父进程创建 Queue,并传给各个子进程:

17. q = Queue()

18. pw = Process(target=write, args=(q,))

19. pr = Process(target=read, args=(q,))

20. # 启动子进程 pw,写入:

21. pw.start()

22. # 等待 pw 结束:

23. pw.join()

24. # 启动子进程 pr,读取:

25. pr.start()

26. pr.join()

27. # pr 进程里是死循环,无法等待其结束,只能强行终止:

28. print('')

29. print('所有数据都写入并且读完')

进程池 Pool

1.# -*- coding:utf-8 -*-

2.from multiprocessing import Poolimport os, time, random

3.def worker(msg):

4. t_start = time.time()

5. print("%s 开始执行,进程号为%d" % (msg,os.getpid()))

6. # random.random()随机生成 0~1 之间的浮点数

7. time.sleep(random.random()*2)

8. t_stop = time.time()

9. print(msg,"执行完毕,耗时%0.2f" % (t_stop-t_start))

10.

11.po = Pool(3) # 定义一个进程池,最大进程数 3

12.for i in range(0,10):

13. # Pool().apply_async(要调用的目标,(传递给目标的参数元祖,))

14. # 每次循环将会用空闲出来的子进程去调用目标

15. po.apply_async(worker,(i,))

16.

17.print("----start----")

18.po.close() # 关闭进程池,关闭后 po 不再接收新的请求

19.po.join() # 等待 po 中所有子进程执行完成,必须放在 close 语句之后

20.print("-----end-----")

multiprocessing.Pool 常用函数解析

- apply_async(func[, args[, kwds]]) :使用非阻塞方式调用 func(并行执行,堵塞方式必须等待上一个进程退出才能执行下一个进程),args 为传递给 func 的参数列表,kwds 为传递给 func的关键字参数列表;

- close():关闭 Pool,使其不再接受新的任务;

- terminate():不管任务是否完成,立即终止;

- join():主进程阻塞,等待子进程的退出, 必须在 close 或 terminate 之后使用;

进程池中使用 Queue

如果要使用 Pool 创建进程,就需要使用 multiprocessing.Manager()中的 Queue(),而不是multiprocessing.Queue(),否则会得到一条如下的错误信息:

RuntimeError: Queue objects should only be shared between processes through inheritance.

1.from multiprocessing import Manager,Poolimport os,time,random

2.def reader(q):

3. print("reader 启动(%s),父进程为(%s)" % (os.getpid(), os.getppid()))

4. for i in range(q.qsize()):

5. print("reader 从 Queue 获取到消息:%s" % q.get(True))

6.def writer(q):

7. print("writer 启动(%s),父进程为(%s)" % (os.getpid(), os.getppid()))

8. for i in "itcast":

9. q.put(i)

10.if __name__=="__main__":

11. print("(%s) start" % os.getpid())

12. q = Manager().Queue() # 使用 Manager 中的 Queue

13. po = Pool()

14. po.apply_async(writer, (q,))

15.

16. time.sleep(1) # 先让上面的任务向 Queue 存入数据,然后再让下面的任务开始从中取数据

17.

18. po.apply_async(reader, (q,))

19. po.close()

20. po.join()

21. print("(%s) End" % os.getpid())

谈谈你对多进程,多线程,以及协程的理解,项目是否用?

- 进程:一个运行的程序(代码)就是一个进程,没有运行的代码叫程序,进程是系统资源分配的最小单位,进程拥有自己独立的内存空间,所以进程间数据不共享,开销大。

- 线程: 调度执行的最小单位,也叫执行路径,不能独立存在,依赖进程存在,一个进程至少有一个线程,叫主线程,而多个线程共享内存(数据共享,共享全局变量),从而极大地提高了程序的运行效率。

- 协程:是一种用户态的轻量级线程,协程的调度完全由用户控制。协程拥有自己的寄存器上下文和栈。 协程调度切换时,将寄存器上下文和栈保存到其他地方,在切回来的时候,恢复先前保存的寄存器上下文和栈,直接操作栈则基本没有内核切换的开销,可以不加锁的访问全局变量,所以上下文的切换非常快。

什么是多线程竞争?

线程是非独立的,同一个进程里线程是数据共享的,当各个线程访问数据资源时会出现竞争状态。即:数据几乎同步会被多个线程占用,造成数据混乱,即所谓的线程不安全。那么怎么解决多线程竞争问题?-- 锁

锁(Lock)是 Python 提供的对线程控制的对象。有互斥锁、可重入锁。

- 锁的好处:确保了某段关键代码(共享数据资源)只能由一个线程从头到尾完整地执行能解决多线程资源竞争下的原子操作问题。

- 锁的坏处:阻止了多线程并发执行,包含锁的某段代码实际上只能以单线程模式执行,效率就大大地下降了锁的致命问题:死锁。

什么是死锁呢?

若干子线程在系统资源竞争时,都在等待对方对某部分资源解除占用状态,结果是谁也不愿先解锁,互相干等着,程序无法执行下去,这就是死锁。

GIL 锁(有时候,面试官不问,你自己要主动说,增加 b 格,尽量别一问一答的尬聊,不然最后等到的一句话就是:你还有什么想问的么?)

GIL锁 全局解释器锁(只在 cpython 里才有)

作用:限制多线程同时执行,保证同一时间只有一个线程执行,所以 cpython 里的多线程其实是伪多线程!

所以 Python 里常常使用协程技术来代替多线程,协程是一种更轻量级的线程,进程和线程的切换时由系统决定,而协程由我们程序员自己决定,而模块 gevent 下切换是遇到了耗时操作才会切换。

三者的关系:进程里有线程,线程里有协程。

什么是线程安全,什么是互斥锁?

每个对象都对应于一个可称为" 互斥锁" 的标记,这个标记用来保证在任一时刻,只能有一个线程访问该对象。

同一个进程中的多线程之间是共享系统资源的,多个线程同时对一个对象进行操作,一个线程操作尚未结束,另一个线程已经对其进行操作,导致最终结果出现错误,此时需要对被操作对象添加互斥锁,保证每个线程对该对象的操作都得到正确的结果。

为什么要用线程池?

- 降低资源消耗。 通过重复利用已创建的线程降低线程创建和销毁造成的消耗。

- 提高响应速度。 当任务到达时,任务可以不需要的等到线程创建就能立即执行。

- 提高线程的可管理性。 线程是稀缺资源,如果无限制的创建,不仅会消耗系统资源,还会降低系统的稳定性,使用线程池可以进行统一的分配,调优和监控

说说下面几个概念:同步,异步,阻塞,非阻塞?

- 同步:多个任务之间有先后顺序执行,一个执行完下个才能执行。

- 异步:多个任务之间没有先后顺序,可以同时执行有时候一个任务可能要在必要的时候获取另一个同时执行的任务的结果,这个就叫回调!

- 阻塞:如果卡住了调用者,调用者不能继续往下执行,就是说调用者阻塞了。

- 非阻塞:如果不会卡住,可以继续执行,就是说非阻塞的。

同步异步相对于多任务而言,阻塞非阻塞相对于代码执行而言。

什么是僵尸进程和孤儿进程?怎么避免僵尸进程?

- 孤儿进程:父进程退出,子进程还在运行的这些子进程都是孤儿进程,孤儿进程将被 init 进程(进程号为 1)所收养,并由 init 进程对它们完成状态收集工作。

- 僵尸进程:进程使用 fork 创建子进程,如果子进程退出,而父进程并没有调用 wait 或 waitpid 获取子进程的状态信息,那么子进程的进程描述符仍然保存在系统中的这些进程是僵尸进程。

- 避免僵尸进程的方法:

- fork 两次用孙子进程去完成子进程的任务;

- 用 wait()函数使父进程阻塞;

- 使用信号量,在 signal handler 中调用 waitpid,这样父进程不用阻塞。

- 避免僵尸进程的方法:

Python 中的进程与线程的使用场景?

多进程适合在 CPU 密集型操作(cpu 操作指令比较多,如位数多的浮点运算)。

多线程适合在 IO 密集型操作(读写数据操作较多的,比如爬虫)。

并行(parallel)和并发(concurrency)?

并行:同一时刻多个任务同时在运行。

并发:在同一时间间隔内多个任务都在运行,但是并不会在同一时刻同时运行,存在交替执行的情况。

实现并行的库有:multiprocessing

实现并发的库有:threading

程序需要执行较多的读写、请求和回复任务的需要大量的 IO 操作,IO 密集型操作使用并发更好。CPU 运算量大的程序使用并行会更好。

线程是并发还是并行,进程是并发还是并行?

线程是并发,进程是并行;

进程之间相互独立,是系统分配资源的最小单位,同一个进程中的所有线程共享资源。

IO 密集型和 CPU 密集型区别?

IO 密集型:系统运作,大部分的状况是 CPU 在等 I/O (硬盘/内存)的读/写。

CPU 密集型:大部份时间用来做计算、逻辑判断等 CPU 动作的程序称之 CPU 密集型。

网络编程

更多网络编程相关内容详见:

socket--- 底层网络接口

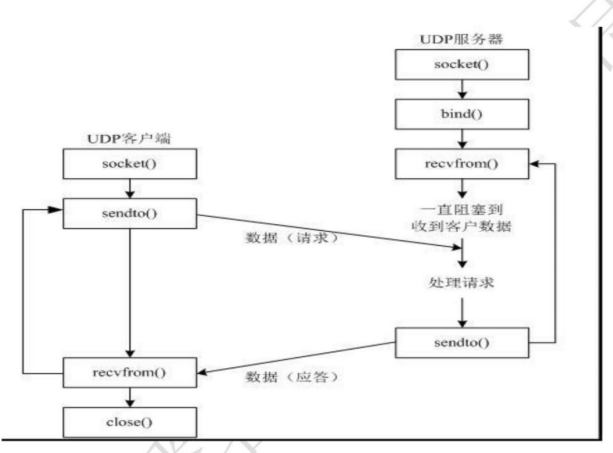

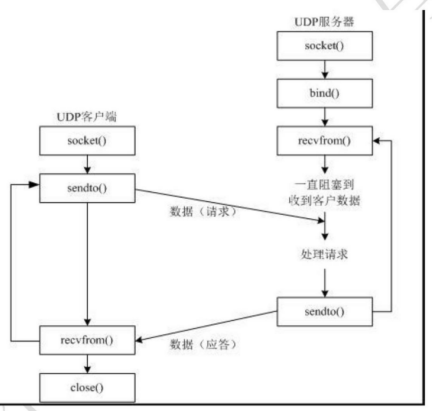

UDP 总结

udp 客户端:

- 创建客户端套接字

- 发送/接收数据

- 关闭套接字

1.import socket

2.def main():

3. # 1、创建 udp 套接字

4. # socket.AF_INET 表示 IPv4 协议 AF_INET6 表示 IPv6 协议

5. # socket.SOCK_DGRAM 数据报套接字,只要用于 udp 协议

6. udp_socket = socket.socket(socket.AF_INET, socket.SOCK_DGRAM)

7.

8. # 2、准备接收方的地址

9. # 元组类型 ip 是字符串类型 端口号是整型

10. dest_addr = ('192.168.113.111', 8888)

11. # 要发送的数据

12. send_data = "我是要发送的数据"

13. # 3、发送数据

14. udp_socket.sendto(send_data.encode("utf-8"), dest_addr)

15. # 4、等待接收方发送的数据 如果没有收到数据则会阻塞等待,直到收到数据

16. # 接收到的数据是一个元组 (接收到的数据, 发送方的 ip 和端口)

17. # 1024 表示本次接收的最大字节数

18. recv_data, addr = udp_socket.recvfrom(1024)

19. # 5、关闭套接字

20. udp_socket.close()

21.if __name__ == '__main__':

22. main()

编码的转换

str -->bytes: encode() 编码

bytes--> str: decode() 解码

UDP 服务器端:

- 创建 socket 套接字

- 绑定端口号

- 接收/发送数据

- 关闭套接字

1.import socket

2.def main():

3. # 1、创建 udp 套接字

4. # socket.AF_INET 表示 IPv4 协议 AF_INET6 表示 IPv6 协议

5. # socket.SOCK_DGRAM 数据报套接字,只要用于 udp 协议

6. udp_socket = socket.socket(socket.AF_INET, socket.SOCK_DGRAM)

7. # 2、绑定端口

8. # 元组类型 ip 一般不写 表示本机的任何的一个 ip

9. local_addr = ('', 7777)

10. udp_socket.bind(local_addr)

11. # 3、准备接收方的地址

12. # 元组类型 ip 是字符串类型 端口号是整型

13. dest_addr = ('192.168.113.111', 8888)

14. # 要发送的数据

15. send_data = "我是要发送的数据"

16. # 4、发送数据

17. udp_socket.sendto(send_data.encode("utf-8"), dest_addr)

18. # 5、等待接收方发送的数据 如果没有收到数据则会阻塞等待,直到收到数据

19. # 接收到的数据是一个元组 (接收到的数据, 发送方的 ip 和端口)

20. # 1024 表示本次接收的最大字节数

21. recv_data, addr = udp_socket.recvfrom(1024)

22. # 6、关闭套接字

23. udp_socket.close()

24.if __name__ == '__main__':

25. main()

注意点:绑定端口要在发送数据之前进行绑定。

TCP 总结

TCP 客户端

- 创建 TCP 的 socket 套接字

- 连接服务器

- 发送数据给服务器端

- 接收服务器端发送来的消息

- 关闭套接字

1.import socket

2.def main():

3. # 1、创建客户端的 socket

4. # socket.AF_INET 表示 IPv4 协议 AF_INET6 表示 IPv6 协议

5. # socket.SOCK_STREAM 流式套接字,只要用于 TCP 协议

6. client_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

7. # 2、构建目标地址

8. server_ip = input("请输入服务器端的 IP 地址:")

9. server_port = int(input("请输入服务器端的端口号:"))

10. # 3、连接服务器

11. # 参数:元组类型 ip 是字符串类型 端口号是整型

12. client_socket.connect((server_ip, server_port))

13. # 要发送给服务器端的数据

14. send_data = "我是要发送给服务器端的数据"

15. # 4、发送数据

16. client_socket.send(send_data.encode("gbk"))

17. # 5、接收服务器端恢复的消息, 没有消息会阻塞

18. # 1024 表示接收的最大字节数

19. recv_date= client_socket.recv(1024)

20. print("接收到的数据是:", recv_date.decode('gbk'))

21. # 6、关闭套接字

22. client_socket.close()

23.if __name__ == '__main__':

24. main()

TCP 服务器端

- 创建 TCP 服务端的 socket

- bing 绑定 ip 地址和端口号

- listen 使套接字变为被动套接字

- accept 取出一个客户端连接,用于服务

- recv/send 接收和发送消息

- 关闭套接字

1.import socket

2.

3.def main():

4. # 1、创建 tcp 服务端的 socket

5. server_socket = socket.socket(socket.AF_INET, socket.SOCK_STREAM)

6.

7. # 2、绑定

8. server_socket.bind(('', 8888))

9.

10. # 3、listen 使套接字变为被动套接字

11. server_socket.listen(128)

12.

13. # 4、如果有新的客户端来链接服务器,那么就产生一个新的套接字专门为这个客户端服务

14. # client_socket 用来为这个客户端服务

15. # tcp_server_socket 就可以省下来专门等待其他新客户端的链接

16. client_socket, client_addr = server_socket.accept()

17.

18. # 5、接收客户端发来的消息

19. recv_data = client_socket.recv(1024)

20. print("接收到客户端%s 的数据:%s" % (str(client_addr), recv_data.decode('gbk')))

21.

22. # 6、回复数据给客户端

23. client_socket.send("收到消息".encode('gbk'))

24.

25. # 7、关闭套接字

26. client_socket.close()

27. server_socket.close()

28.

29.if __name__ == '__main__':

30. main()

注意点:

- tcp 服务器一般都需要绑定,否则客户端找不到服务器

- tcp 客户端一般不绑定,因为是主动链接服务器,所以只要确定好服务器的 ip、port 等信息就好,本地客户端可以随机

- tcp 服务器中通过 listen 可以将 socket 创建出来的主动套接字变为被动的,这是做 tcp 服务器时必须要做的

- 当客户端需要链接服务器时,就需要使用 connect 进行链接,udp 是不需要链接的而是直接发送,但是 tcp 必须先链接,只有链接成功才能通信

- 当一个 tcp 客户端连接服务器时,服务器端会有 1 个新的套接字,这个套接字用来标记这个客户端,单独为这个客户端服务

- listen 后的套接字是被动套接字,用来接收新的客户端的连接请求的,而 accept 返回的新套接字是标识这个新客户端的

- 关闭 listen 后的套接字意味着被动套接字关闭了,会导致新的客户端不能够链接服务器,但是之前已经链接成功的客户端正常通信。

- 关闭 accept 返回的套接字意味着这个客户端已经服务完毕

- 当客户端的套接字调用 close 后,服务器端会 recv 解阻塞,并且返回的长度为 0,因此服务器可以通过返回数据的长度来区别客户端是否已经下线;同理,当服务器断开 tcp 连接的时候客户端同样也会收到 0 字节数据。

怎么实现强行关闭客户端和服务器之间的连接?

在 socket 通信过程中不断循环检测一个全局变量(开关标记变量),一旦标记变量变为关闭,则调用 socket 的 close 方法,循环结束,从而达到关闭连接的目的。

简述 TCP 和 UDP 的区别以及优缺点?

UDP 是面向无连接的通讯协议,UDP 数据包括目的端口号和源端口号信息。

优点:UDP 速度快、操作简单、要求系统资源较少,由于通讯不需要连接,可以实现广播发送

缺点:UDP 传送数据前并不与对方建立连接,对接收到的数据也不发送确认信号,发送端不知道数据是否会正确接收,也不重复发送,不可靠。

TCP 是面向连接的通讯协议,通过三次握手建立连接,通讯完成时四次挥手

优点:TCP 在数据传递时,有确认、窗口、重传、阻塞等控制机制,能保证数据正确性,较为可靠。

缺点:TCP 相对于 UDP 速度慢一点,要求系统资源较多。

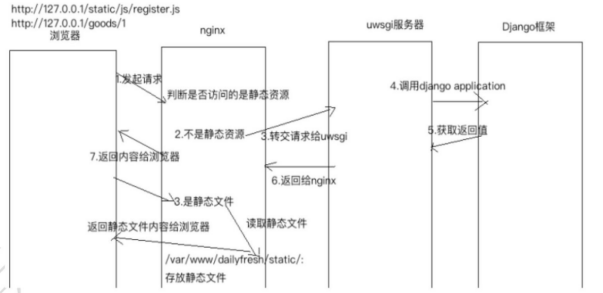

简述浏览器通过 WSGI 请求动态资源的过程?

- 发送 http 请求动态资源给 web 服务器

- web 服务器收到请求后通过 WSGI 调用一个属性给应用程序框架

- 应用程序框架通过引用 WSGI 调用 web 服务器的方法,设置返回的状态和头信息。

- 调用后返回,此时 web 服务器保存了刚刚设置的信息

- 应用程序框架查询数据库,生成动态页面的 body 的信息

- 把生成的 body 信息返回给 web 服务器

- web 服务器把数据返回给浏览器

描述用浏览器访问 www.baidu.com 的过程

- 要先使用 rarp 获取默认网关的 mac 地址

- 组织数据发送给默认网关(ip 还是 dns 服务器的 ip,但是 mac 地址是默认网关的 mac 地址)

- 默认网关拥有转发数据的能力,把数据转发给路由器

- 路由器根据自己的路由协议,来选择一个合适的较快的路径转发数据给目的网关

- 目的网关(dns 服务器所在的网关),把数据转发给 dns 服务器

- dns 服务器查询解析出 baidu.com 对应的 ip 地址,并原路返回请求这个域名的 client 得到了 baidu.com 对应的 ip 地址之后,会发送 tcp 的 3 次握手,进行连接

- 使用 http 协议发送请求数据给 web 服务器

- web 服务器收到数据请求之后,通过查询自己的服务器得到相应的结果,原路返回给浏览器。

- 浏览器接收到数据之后通过浏览器自己的渲染功能来显示这个网页。

- 浏览器关闭 tcp 连接,即 4 次挥手结束,完成整个访问过程

Post 和 Get 请求的区别?

GET 请求:请求的数据会附加在 URL 之后,以?分割 URL 和传输数据,多个参数用&连接。URL 的编码格式采用的是 ASCII 编码,而不是 uniclde,即是说所有的非 ASCII 字符都要编码之后再传输。

POST 请求:POST 请求会把请求的数据放置在 HTTP 请求包的包体中。上面的 item=bandsaw 就是实际的传输数据。

GET 请求的数据会暴露在地址栏中,而 POST 请求则不会。

传输数据的大小:在 HTTP 规范中,没有对 URL 的长度和传输的数据大小进行限制。但是在实际开发过程中,对于 GET,特定的浏览器和服务器对 URL 的长度有限制。因此,在使用 GET 请求时,传输数据会受到 URL 长度的限制。对于 POST,由于不是 URL 传值,理论上是不会受限制的,但是实际上各个服务器会规定对 POST提交数据大小进行限制,Apache、IIS 都有各自的配置。

安全性:POST 的安全性比 GET 的高。这里的安全是指真正的安全,而不同于上面 GET 提到的安全方法中的安全,上面提到的安全仅仅是不修改服务器的数据。比如,在进行登录操作,通过 GET 请求,用户名和密码都会暴露再 URL 上,因为登录页面有可能被浏览器缓存以及其他人查看浏览器的历史记录的原因,此时的用户名和密码就很容易被他人拿到了。除此之外,GET 请求提交的数据还可能会造成 Cross-site request frogery 攻击。

效率:GET 比 POST 效率高。

POST 请求的过程

- 浏览器请求 tcp 连接(第一次握手)

- 服务器答应进行 tcp 连接(第二次握手)

- 浏览器确认,并发送 post 请求头(第三次握手,这个报文比较小,所以 http 会在此时进行第一次数据发送)

- 服务器返回 100 continue 响应

- 浏览器开始发送数据

- 服务器返回 200 ok 响应

GET 请求的过程

- 浏览器请求 tcp 连接(第一次握手)

- 服务器答应进行 tcp 连接(第二次握手)

- 浏览器确认,并发送 get 请求头和数据(第三次握手,这个报文比较小,所以 http 会在此时进行第一次数据发送)

- 服务器返回 200 OK 响应

cookie 和 session 的区别?

- cookie 数据存放在客户的浏览器上,session 数据放在服务器上。

- cookie 不是很安全,别人可以分析存放在本地的 cookie 并进行 cookie 欺骗考虑到安全应当使用session。

- session 会在一定时间内保存在服务器上。当访问增多,会比较占用服务器的性能考虑到减轻服务器性能方面,应当使用 cookie。

- 单个 cookie 保存的数据不能超过 4K,很多浏览器都限制一个站点最多保存 20 个 cookie。

建议: 将登陆信息等重要信息存放为 SESSION;其他信息如果需要保留,可以放在 cookie 中

HTTP 协议状态码有什么用,列出你知道的 HTTP 协议的状态码,然后讲出他们都表示什么意思?

通过状态码告诉客户端服务器的执行状态,以判断下一步该执行什么操作。

常见的状态机器码有:

- 100-199:表示服务器成功接收部分请求,要求客户端继续提交其余请求才能完成整个处理过程。

- 200-299:表示服务器成功接收请求并已完成处理过程,常用 200(OK 请求成功)。

- 300-399:为完成请求,客户需要进一步细化请求。302(所有请求页面已经临时转移到新的 url)。304、307(使用缓存资源)。

- 400-499:客户端请求有错误,常用 404(服务器无法找到被请求页面),403(服务器拒绝访问,权限不够)。

- 500-599:服务器端出现错误,常用 500(请求未完成,服务器遇到不可预知的情况)。

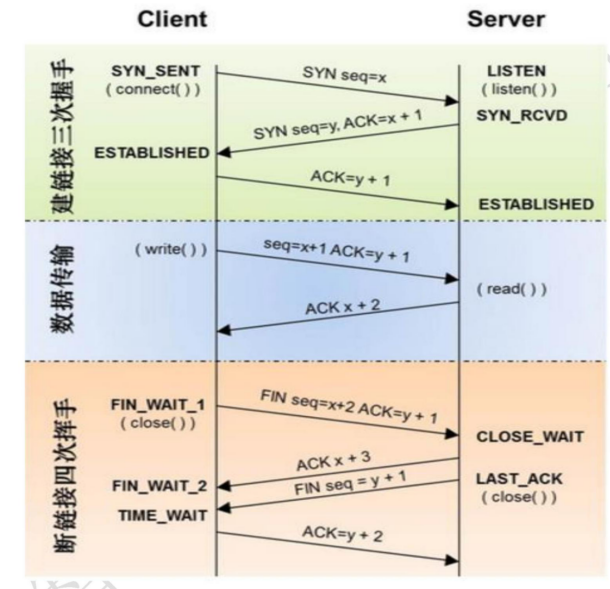

请简单说一下三次握手和四次挥手?

三次握手过程:

- 首先客户端向服务端发送一个带有 SYN 标志,以及随机生成的序号 100(0 字节)的报文

- 服务端收到报文后返回一个报文(SYN200(0 字节),ACk1001(字节+1))给客户端

- 客户端再次发送带有 ACk 标志 201(字节+)序号的报文给服务端

至此三次握手过程结束,客户端开始向服务端发送数据。

补充:SYN:请求询问,ACk:回复,回应。

- 客户端向服务端发起请求:我想给你通信,你准备好了么?

- 服务端收到请求后回应客户端:I'ok,你准备好了么

- 客户端礼貌的再次回一下客户端:准备就绪,咱们开始通信吧!

整个过程跟打电话的过程一模一样:1 喂,你在吗 2 在,我说的你听得到不 3 恩,听得到(接下来请开始你的表演)

四次挥手过程:

由于 TCP 连接是可以双向通信的(全双工),因此每个方向都必须单独进行关闭(这句话才是精辟,后面四个挥手过程都是其具体实现的语言描述)

四次挥手过程,客户端和服务端都可以先开始断开连接

- 客户端发送带有 fin 标识的报文给服务端,请求通信关闭

- 服务端收到信息后,回复 ACK 答应关闭客户端通信(连接)请求

- 服务端发送带有 fin 标识的报文给客户端,也请求关闭通信

- 客户端回应 ack 给服务端,答应关闭服务端的通信(连接)请求

说一下什么是 tcp 的 2MSL?

主动发送 fin 关闭的一方,在 4 次挥手最后一次要等待一段时间我们称这段时间为 2MSL。TIME_WAIT 状态的存在有两个理由:

- 让 4 次挥手关闭流程更加可靠

- 防止丢包后对后续新建的正常连接的传输造成破坏

为什么客户端在 TIME-WAIT 状态必须等待 2MSL 的时间?

- 为了保证客户端发送的最后一个 ACK 报文段能够达到服务器。这个 ACK 报文段可能丢失,因而使处在 LAST-ACK 状态的服务器收不到确认。服务器会超时重传 FIN+ACK 报文段,客户端就能在 2MSL 时间内收到这个重传的 FIN+ACK 报文段,接着客户端重传一次确认,重启计时器。最好,客户端和服务器都正常进入到 CLOSED 状态。如果客户端在 TIME-WAIT 状态不等待一段时间,而是再发送完 ACK 报文后立即释放连接,那么就无法收到服务器重传的 FIN+ACK 报文段,因而也不会再发送一次确认报文。这样,服务器就无法按照正常步骤进入 CLOSED 状态。

- 防止已失效的连接请求报文段出现在本连接中。客户端在发送完最后一个 ACK 确认报文段后,再经过时间 2MSL,就可以使本连接持续的时间内所产生的所有报文段都从网络中消失。这样就可以使下一个新的连接中不会出现这种旧的连接请求报文段。

其他

说说 HTTP 和 HTTPS 区别?

HTTP 协议传输的数据都是未加密的,也就是明文的,因此使用 HTTP 协议传输隐私信息非常不安全,为了保证这些隐私数据能加密传输,于是网景公司设计了 SSL(Secure Sockets Layer)协议用于

对 HTTP 协议传输的数据进行加密,从而就诞生了 HTTPS。简单来说,HTTPS 协议是由 SSL+HTTP 协议构建的可进行加密传输、身份认证的网络协议,要比 http 协议安全。

HTTPS 和 HTTP 的区别主要如下:

- https 协议需要到 ca 申请证书,一般免费证书较少,因而需要一定费用。

- http 是超文本传输协议,信息是明文传输,https 则是具有安全性的 ssl 加密传输协议。

- http 和 https 使用的是完全不同的连接方式,用的端口也不一样,前者是 80,后者是 443。

- http 的连接很简单,是无状态的;HTTPS 协议是由 SSL+HTTP 协议构建的可进行加密传输、身份认证的网络协议,比 http 协议安全。

谈一下 HTTP 协议以及协议头部中表示数据类型的字段?

HTTP 协议是 Hyper Text Transfer Protocol(超文本传输协议)的缩写,是用于从万维网(WWW:World Wide Web)服务器传输超文本到本地浏览器的传送协议。

HTTP 是一个基于 TCP/IP 通信协议来传递数据(HTML 文件, 图片文件, 查询结果等)。

HTTP 是一个属于应用层的面向对象的协议,由于其简捷、快速的方式,适用于分布式超媒体信息系统。它于1990 年提出,经过几年的使用与发展,得到不断地完善和扩展。目前在 WWW 中使用的是 HTTP/1.0 的第六版,HTTP/1.1 的规范化工作正在进行之中,而且 HTTP-NG(Next Generation of HTTP)的建议已经提出。

HTTP 协议工作于客户端-服务端架构为上。浏览器作为 HTTP 客户端通过 URL 向 HTTP 服务端即 WEB 服务器发送所有请求。Web 服务器根据接收到的请求后,向客户端发送响应信息。

表示数据类型字段: Content-Type

HTTP 请求方法都有什么?

根据 HTTP 标准,HTTP 请求可以使用多种请求方法。

HTTP1.0 定义了三种请求方法: GET, POST 和 HEAD 方法。

HTTP1.1 新增了五种请求方法:OPTIONS, PUT, DELETE, TRACE 和 CONNECT 方法。

- GET 请求指定的页面信息,并返回实体主体。

- HEAD 类似于 get 请求,只不过返回的响应中没有具体的内容,用于获取报头。

- POST 向指定资源提交数据进行处理请求(例如提交表单或者上传文件)。数据被包含在请求体中。POST 请求可能会导致新的资源的建立和/或已有资源的修改。

- PUT 从客户端向服务器传送的数据取代指定的文档的内容。

- DELETE请求服务器删除指定的页面。

- CONNECT HTTP/1.1 协议中预留给能够将连接改为管道方式的代理服务器。

- OPTIONS 允许客户端查看服务器的性能。

- TRACE 回显服务器收到的请求,主要用于测试或诊断。

使用 Socket 套接字需要传入哪些参数 ?

- Address Family表示套接字应用场景

- Type表示类型。

- family

- AF_UNIX(Unix 域,用于同一台机器上的进程间通讯)

- AF_INET(对于 IPV4 协议的 TCP 和 UDP)

- type 参数

- SOCK_STREAM(流套接字)

- SOCK_DGRAM(数据报文套接字)

- SOCK_RAW(raw 套接字)

HTTP 常见请求头?

- Host (主机和端口号)

- Connection (链接类型)

- Upgrade-Insecure-Requests (升级为 HTTPS 请求)

- User-Agent (浏览器名称)

- Accept (传输文件类型)

- Referer (页面跳转处)

- Accept-Encoding(文件编解码格式)

- Cookie (Cookie)

- x-requested-with :XMLHttpRequest (是 Ajax 异步请求)

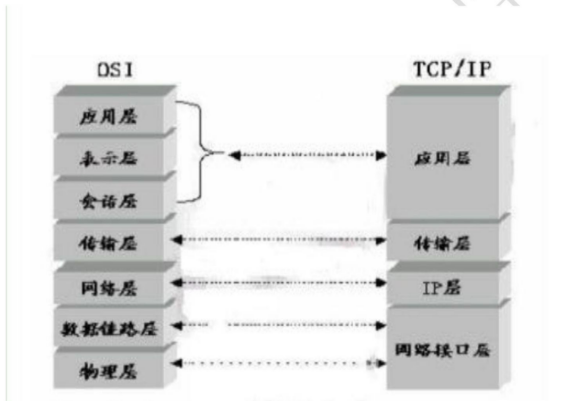

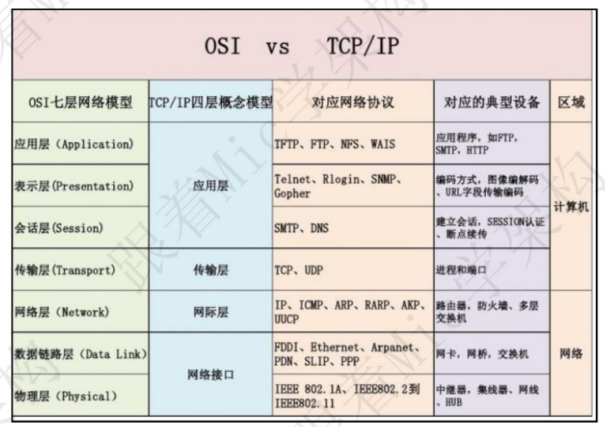

七层模型? IP ,TCP/UDP ,HTTP ,RTSP ,FTP 分别在哪层?

- IP: 网络层

- TCP/UDP: 传输层

- HTTP、RTSP、FTP: 应用层协议

url 的形式?

形式: scheme://host[:port#]/path/…/[?query-string][#anchor]

- scheme:协议(例如:http, https, ftp)

- host:服务器的 IP 地址或者域名

- port:服务器的端口(如果是走协议默认端口,80 or 443)

- path:访问资源的路径

- query-string:参数,发送给 http 服务器的数据

- anchor:锚(跳转到网页的指定锚点位置)

其他

面向对象和面向过程的区别

面向过程:是分析解决问题的步骤,然后用函数把这些步骤一步一步地实现,然后在使用的时候一一调用则可。性能较高,所以单片机、嵌入式开发等一般采用面向过程开发

面向对象:是把构成问题的事务分解成各个对象,而建立对象的目的也不是为了完成一个个步骤,而是为了描述某个事物在解决整个问题的过程中所发生的行为。面向对象有封装、继承、多态的特性,所以 易维护、易复用、易扩展。可以设计出低耦合的系统。 但是性能上来说,比面向过程要低。

代码优化从哪些方面考虑?有什么想法?

-

优化算法时间复杂度。

算法的时间复杂度对程序的执行效率影响最大,在 Python 中可以通过选择合适的数据结构来优化时间复杂度,如 list 和 set 查找某一个元素的时间复杂度分别是 O(n)和 O(1)。不同的场景有不同的优化方式,总得来说,一般有分治,分支界限,贪心,动态规划等思想。

-

减少冗余数据。

-

合理使用 copy 与 deepcopy。

-

使用 dict 或 set 查找元素。

set 的 union,intersection,difference 操作要比 list 的迭代要快。因此如果涉及到求 list 交集,并集或者差的问题可以转换为 set 来操作。

-

合理使用生成器(generator)和 yield。

-

优化循环。

每种编程语言都会强调需要优化循环。当使用 Python 的时候,你可以依靠大量的技巧使得循环运行得更快。然而,开发者经常漏掉的一个方法是:避免在一个循环中使用点操作。每一次你调用方法 str.upper,Python 都会求该方法的值。然而,如果你用一个变量代替求得的值,值就变成了已知的,Python 就可以更快地执行任务。优化循环的关键,是要减少 Python 在循环内部执行的工作量,因为 Python 原生的解释器在那种情况下,真的会减缓执行的速度。(注意:优化循环的方法有很多,这只是其中的一个。例如,许多程序员都会说,列表推导是在循环中提高执行速度的最好方式。这里的关键是,优化循环是程序取得更高的执行速度的更好方式之一。)

-

优化包含多个判断表达式的顺序。

-

使用 join 合并迭代器中的字符串。

-

选择合适的格式化字符方式。

-

不借助中间变量交换两个变量的值。

-

使用 if is。

-

使用级联比较 x < y < z。

-

while 1 比 while True 更快。

-

使用**而不是 pow。

-

使用 cProfile, cStringIO 和 cPickle 等用 c 实现相同功能(分别对应 profile, StringIO, pickle) 的包。

-

使用最佳的反序列化方式。

-

使用 C 扩展(Extension)。

-

并行编程

因为 GIL 的存在,Python 很难充分利用多核 CPU 的优势。但是,可以通过内置的模块multiprocessing 实现下面几种并行模式:

-

多进程:对于 CPU 密集型的程序,可以使用 multiprocessing 的 Process,Pool 等封装好的类,通过多进程的方式实现并行计算。但是因为进程中的通信成本比较大,对于进程之间需要大量数据交互的程序效率未必有大的提高。

-

多线程:对于 IO 密集型的程序,multiprocessing.dummy 模块使用 multiprocessing 的接口封装 threading,使得多线程编程也变得非常轻松(比如可以使用 Pool 的 map 接口,简洁高效)。

-

分布式:multiprocessing 中的 Managers 类提供了可以在不同进程之共享数据的方式,可以在此基础上开发出分布式的程序

不同的业务场景可以选择其中的一种或几种的组合实现程序性能的优化。

-

-

使用性能分析工具

除了上面在 ipython 使用到的 timeit 模块,还有 cProfile。cProfile 的使用方式也非常简单:python-mcProfile,filename.py 是要运行程序的文件名,可以在标准输出中看到每一个函数被调用的次数和运行的时间,从而找到程序的性能瓶颈,然后可以有针对性地优化。

-

PyPy

PyPy 是用 RPython(CPython 的子集)实现的 Python,根据官网的基准测试数据,它比 CPython实现的 Python 要快 6 倍以上。快的原因是使用了 Just-in-Time(JIT)编译器,即动态编译器,与静态编译器(如 gcc,javac 等)不同,它是利用程序运行的过程的数据进行优化。由于历史原因,目前 pypy中还保留着 GIL,不过正在进行的 STM 项目试图将 PyPy 变成没有 GIL 的 Python。如果 python程序中含有 C 扩展(非 cffi 的方式),JIT 的优化效果会大打折扣,甚至比 CPython 慢(比 Numpy)。所以在 PyPy 中最好用纯 Python 或使用 cffi 扩展。

三、前端

Html

CSS

什么是 CSS 初始化?有什么好处?

CSS 初始化是指重设浏览器的样式。不同的浏览器默认的样式可能不尽相同,如果没对 CSS 初始化往往会出现浏览器之间的页面差异。

好处:能够统一标签在各大主流浏览器中的默认样式,使得我们开发网页内容时更加方便简洁,同时减少 CSS 代码量,节约网页下载时间。

简述浮动的特征和清除浮动的方法?

浮动的特征:

- 浮动元素有左浮动(float:left)和右浮动(float:right)两种。

- 浮动的元素会向左或向右浮动,碰到父元素边界、其他元素才停下来。

- 相邻浮动的块元素可以并在一行,超出父级宽度就换行。

- 浮动让行内元素或块元素转化为有浮动特性的行内块元素(此时不会有行内块元素间隙问题)。

- 父元素如果没有设置尺寸(一般是高度不设置),父元素内整体浮动的子元素无法撑开父元素,父元素需要清除浮动。

清除浮动的方法:

-

父级上增加属性 overflow:hidden。

-

在最后一个子元素的后面加一个空的 div,给它样式属性 clear:both。

-

使用成熟的清浮动样式类,clearfix。

1. .clearfix:after,.clearfix:before{ content: "";display: table;} 2. .clearfix:after{ clear:both;} 3. .clearfix{zoom:1;}

JavaScript

AJAX 是什么?如何使用 AJAX?

ajax(异步的 javascript 和 xml) 能够刷新局部网页数据而不是重新加载整个网页。

- 创建 xmlhttprequest 对象,var xmlhttp =new XMLHttpRequest();XMLHttpRequest对象用来和服务器交换数据。

- 使用 xmlhttprequest 对象的 open()和 send()方法发送资源请求给服务器。

- 使用 xmlhttprequest 对象的 responseText 或 responseXML 属性获得服务器的响应。

- onreadystatechange 函数,当发送请求到服务器,我们想要服务器响应执行一些功能就需要使用onreadystatechange 函数,每次 xmlhttprequest 对象的 readyState 发生改变都会触发onreadystatechange 函数。

jQurey

vue.js

四、Web

Flask

Flask 中正则 URL 的实现?

@app.route('

-

写正则类,继承 BaseConverter,将匹配到的值设置为 regex 的值。

1. class RegexUrl(BaseConverter): 2. def __init__(self, url_map, *args): 3. super(RegexUrl, self).__init__(url_map) 4. self.regex = args[0] -

把正则类赋值给我们定义的正则规则。

5. app.url_map.converters['re'] = RegexUrl -

在 URL 中使用正则。

6. @app.route('/regex/<re("[a-z]{3}"):id>') 7. def regex111(id): 8. return 'id:%s'%id

Flask 中请求上下文和应用上下文的区别和作用?

current_app、g 是应用上下文。

request、session 是请求上下文。

手动创建上下文的两种方法:

1. with app.app_context()

2. app = current_app._get_current_object()

两者区别:

请求上下文:保存了客户端和服务器交互的数据。

应用上下文:flask 应用程序运行过程中,保存的一些配置信息,比如程序名、数据库连接、应用信息等。

两者作用:

请求上下文(request context):Flask 从客户端收到请求时,要让视图函数能访问一些对象,这样才能处理请求。请求对象是一个很好的例子,它封装了客户端发送的 HTTP 请求。要想让视图函数能够访问请求对象,一个显而易见的方式是将其作为参数传入视图函数,不过这会导致程序中的每个视图函数都增加一个参数,除了访问请求对象,如果视图函数在处理请求时还要访问其他对象,情况会变得更糟。为了避免大量可有可无的参数把视图函数弄得一团糟,Flask使用上下文临时把某些对象变为全局可访问。

应用上下文(application context):它的字面意思是应用上下文,但它不是一直存在的,它只是 request context 中的一个对 app的代理(人),所谓 local proxy。它的作用主要是帮助 request 获取当前的应用,它是伴 request 而生,随 request 而灭的。

Flask 中数据库设置?

| 名字 | 备注 |

|---|---|

| SQLALCHEMY_DATABASE_URI | 用于连接的数据库URI。例如:sqlite:/ll/tmp/test.dbmysql://username:password@server/db |

| SQLALCHEMY_BINDS | —个映射binds 到连接URI的字典。更多binds 的信息见用Binds操作多个数据库。 |

| SQLALCHEMY_ECHO | 如果设置为Ture , SQLAlchemy 会记录所有发给stderr 的语句,这对调试有用。(打印sql语句) |

| SQLALCHEMY_RECORD_QUERIES | 可以用于显式地禁用或启用查询记录。查询记录在调试或测试模式自动启用。更多信息见get_debug_querieso. |

| SQLALCHEMY_NATIVE_UNICODE | 可以用于显式禁用原生unicode 支持。当使用不合适的指定无编码的数据库默认值时,这对于一些数据库适配器是必须的(比如Ubuntu 上某些版本的PostgresQL )。 |

| SQLALCHEMY_POOL_SlZE | 数据库连接池的大小。默认是引擎默认值(通常是5) |

| SQLALCHEMY_POOL_TIMEOUT | 设定连接池的连接超时时间。默认是10。 |

| SQLALCHEMY_POOL_RECYCLE | 多少秒后自动回收连接。这对 MySQL是必要的,它默认移除闲置多于8小时的连接。注意如果使用了MySQL , Flask-SQLALchemy自动设定这个值为2小时。 |

| SQLALCHEMY_COMMIT_ON_TEARDOWN | 可以配置请求执行完逻辑之后自动提交,而不用我们每次都手动调用 session.commit() |

| SQLALCHEMY_TRACK_MODIFICATIONS | 显示打印的数据以及 sql 语句,建议不设置,默认为 False |

常用的 SQLAlchemy 查询过滤器?

| 过滤器 | 说明 |

|---|---|

| filter() | 把过滤器添加到原查询上,返回一个新查询 |

| filter_by() | 把等值过滤器添加到原查询上,返回一个新查询 |

| limit | 使用指定的值限定原查询返回的结果 |

| offset() | 偏移原查询返回的结果,返回一个新查询 |

| order_by() | 根据指定条件对原查询结果进行排序,返回一个新查询 |

| group_by() | 根据指定条件对原查询结果进行分组,返回一个新查询 |

对 Flask 蓝图(Blueprint)的理解?

蓝图的定义

蓝图 /Blueprint 是 Flask 应用程序组件化的方法,可以在一个应用内或跨越多个项目共用蓝图。使用蓝图可以极大地简化大型应用的开发难度,也为 Flask 扩展提供了一种在应用中注册服务的集中式机制。

蓝图的应用场景

- 把一个应用分解为一个蓝图的集合。这对大型应用是理想的。一个项目可以实例化一个应用对象,初始化几个扩展,并注册一集合的蓝图。

- 以 URL 前缀和/或子域名,在应用上注册一个蓝图。 URL 前缀/子域名中的参数即成为这个蓝图下的所有视图函数的共同的视图参数(默认情况下)。

- 在一个应用中用不同的 URL 规则多次注册一个蓝图。

- 通过蓝图提供模板过滤器、静态文件、模板和其它功能。一个蓝图不一定要实现应用或者视图函数。

- 初始化一个 Flask 扩展时,在这些情况中注册一个蓝图。

蓝图的缺点

不能在应用创建后撤销注册一个蓝图而不销毁整个应用对象。

使用蓝图的三个步骤

-

创建 一个蓝图对象

blue = Blueprint("blue",__name__) -

在这个蓝图对象上进行操作 ,例如注册路由、指定静态文件夹、注册模板过滤器...

@blue.route('/') def blue_index(): return 'Welcome to my blueprint' -

在应用对象上注册这个蓝图对象

app.register_blueprint(blue,url_prefix='/blue')

Flask 中 WTF 表单数据验证?

在 Flask 中,为了处理 web 表单,我们一般使用 Flask-WTF 扩展,它封装了 WTForms,并且它有验证表单数据的功能。

WTForms 支持的 HTML 标准字段:

| 字段对象 | 说明 |

|---|---|

| StringField | 文本字段 |

| TextAreaField | 多行文本字段 |

| PasswordField | 密码文本字段 |

| HiddenField | 隐藏文件字段 |

| DateField | 文本字段,值为 datetime.date 文本格式 |

| DateTimeField | 文本字段,值为 datetime.datetime 文本格式 |

| IntegerField | 文本字段,值为整数 |

| DecimalField | 文本字段,值为 decimal.Decimal |

| FloatField | 文本字段,值为浮点数 |

| BooleanField | 复选框,值为 True 和 False |

| RadioField | 一组单选框 |

| SelectField | 下拉列表 |

| SelectMutipleField | 下拉列表,可选择多个值 |

| FileField | 文件上传字段 |

| SubmitField | 表单提交按钮 |

| FormField | 把表单作为字段嵌入另一个表单 |

| FieldList | 一组指定类型的字段 |

WTForms 常用验证函数:

| 验证函数 | 说明 |

|---|---|

| InputRequired | 确保字段中有数据 |

| DataRequired | 确保字段中有数据并且数据为真 |

| EqualTo | 比较两个字段的值,常用于比较两次密码输入 |

| Length | 验证输入的字符串长度 |

| NumberRange | 验证输入的值在数字范围内 |

| URL | 验证 URL |

| AnyOf | 验证输入值在可选列表中 |

| NoneOf | 验证输入值不在可选列表中 |

使用 Flask-WTF 需要配置参数 SECRET_KEY。

CSRF_ENABLED 是为了 CSRF(跨站请求伪造)保护。 SECRET_KEY 用来生成加密令牌,当 CSRF 激活的时候,该设置会根据设置的密匙生成加密令牌。

Flask 项目中如何实现 session 信息的写入?

Flask 中有三个 session:

- 数据库中的 session,例如:db.session.add()

- 在 flask_session 扩展中的 session,使用:from flask_session import Session,使用第三方扩展的 session 可以把信息存储在服务器中,客户端浏览器中只存储 sessionid。

- flask 自带的 session,是一个请求上下文, 使用:from flask import session。自带的session 把信息加密后都存储在客户端的浏览器 cookie 中。

项目接口实现后路由访问不到怎么办?

- 可以通过 postman 测试工具测试

- 看 log 日志信息找到错误信息的大概位置

- 断点调试

Flask 中 url_for 函数?

-

URL 反转:根据视图函数名称得到当前所指向的 url。

-

url_for() 函数最简单的用法是以视图函数名作为参数,返回对应的 url,还可以用作加载静态文件。

<link rel="stylesheet" href="{{url_for('static',filename='css/index.css')}}">该条语句就是在模版中加载 css 静态文件。

-

url_for 和 redirect 区别

-

url_for 是用来拼接 URL 的,可以使用程序 URL 映射中保存的信息生成 URL。url_for() 函数最简单的用法是以视图函数名作为参数, 返回对应的 URL。例如,在示例程序中 hello.py 中调用url_for('index') 得到的结果是 /。

-

redirect 是重定向函数,输入一个 URL 后,自动跳转到另一个 URL 所在的地址,例如,你在函数 中写 return redirect('https://www.baidu.com') 页面就会跳转向百度页面。

1. from flask import Flask,redirect,url_for 2. app = Flask(__name__) 3. @app.route('/') 4. def index(): 5. login_url = url_for('login') 6. return redirect(login_url) 7. return u'这是首页' 8. 9. @app.route('/login/') 10.def login(): 11. return u'这是登陆页面' 12. 13. @app.route('/question/<is_login>/') 14. def question(is_login): 15. if is_login == '1': 16. return u'这是发布问答的页面' 17. else: 18. return redirect(url_for('login')) 19. 20. if __name__ == '__main__': 21. app.run(debug=True)

-

Flask 中请求钩子的理解和应用?

请求钩子是通过装饰器的形式实现的,支持以下四种:

- before_first_request 在处理第一个请求前运行

- before_request:在每次请求前运行

- after_request:如果没有未处理的异常抛出,在每次请求后运行

- teardown_request:即使有未处理的异常抛出,在每次请求后运行

应用:

1. @api.after_request

2. def after_request(response):

3. """设置默认的响应报文格式为 application/json"""

4. # 如果响应报文response的Content-Type是以text开头,则将其改为默认的 json 类型

5. if response.headers.get("Content-Type").startswith("text"):

6. response.headers["Content-Type"] = "application/json"

7. return respon

一个变量后写多个过滤器是如何执行的?

{{ expression | filter1 | filter2 | ... }} 即表达式(expression)使用 filter1 过滤后再将 filter1 的结果去使用 filter2 过滤。

如何把整个数据库导出来,再导入指定数据库中?

导出:

mysqldump [-h 主机] -u 用户名 -p 数据库名 > 导出的数据库名.sql

导入指定的数据库中:

方法一:

mysqldump [-h 主机] -u 用户名 -p 数据库名 < 导出的数据库名.sql

方法二:

先创建好数据库,因为导出的文件里没有创建数据库的语句,如果数据库已经建好,则不用再创建

create database example charset=utf8;(数据库名可以不一样)

切换数据库:

use example;

导入指定 sql 文件:

mysql>source /path/example.sql;

Flask 和 Django 路由映射的区别?

在 django 中,路由是浏览器访问服务器时,先访问的项目中的 url,再由项目中的 url 找到应用中url,这些 url 是放在一个列表里,遵从从前往后匹配的规则。在 flask 中,路由是通过装饰器给每个视图函数提供的,而且根据请求方式的不同可以一个 url 用于不同的作用。

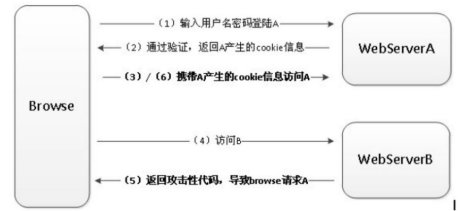

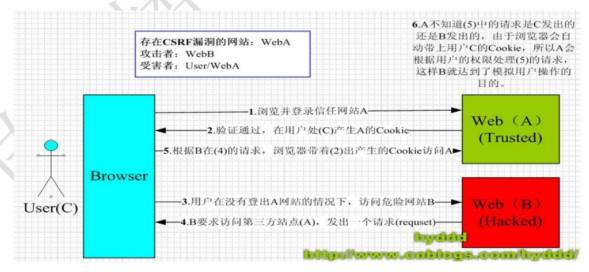

跨站请求伪造和跨站请求保护的实现?

图中 Browse 是浏览器,WebServerA 是受信任网站/被攻击网站 A,WebServerB 是恶意网站/点击网站 B。

- 一开始用户打开浏览器,访问受信任网站 A,输入用户名和密码登陆请求登陆网站 A。

- 网站 A 验证用户信息,用户信息通过验证后,网站 A 产生 Cookie 信息并返回给浏览器。

- 用户登陆网站 A 成功后,可以正常请求网站 A。

- 用户未退出网站 A 之前,在同一浏览器中,打开一个 TAB 访问网站 B。

- 网站 B 看到有人方式后,他会返回一些攻击性代码。

- 浏览器在接受到这些攻击性代码后,促使用户不知情的情况下浏览器携带 Cookie(包括sessionId)信息,请求网站 A。这种请求有可能更新密码,添加用户什么的操作。

从上面 CSRF 攻击原理可以看出,要完成一次 CSRF 攻击,需要被攻击者完成两个步骤:

- 登陆受信任网站 A,并在本地生成 COOKIE。

- 在不登出 A 的情况下,访问危险网站 B。

如果不满足以上两个条件中的一个,就不会受到 CSRF 的攻击,以下情况可能会导致 CSRF:

- 登录了一个网站后,打开一个 tab 页面并访问另外的网站。

- 关闭浏览器了后,本地的 Cookie 尚未过期,你上次的会话还没有已经结束。(事实上,关闭浏览器不能结束一个会话,但大多数人都会错误的认为关闭浏览器就等于退出登录/结束会话了……)

解决办法:就是在表单中添加 from.csrf_token。

Flask(__name__)中的__name__可以传入哪些值?

可以传入的参数:

- 字符串:‘hello’;但是‘abc’,不行,因为 abc 是 python 内置的模块

- _name_,约定俗成

不可以插入的参数:

- python 内置的模块,re,urllib,abc 等

- 数字

更多flask相关内容详见:

Flask文档

Django

Django 创建项目的命令?

django-admin startproject 项目名称

python manage.py startapp 应用app名

Django 创建项目后,项目文件夹下的组成部分(对 mvt 的理解)?

项目文件夹下的组成部分:

- manage.py 是项目运行的入口,指定配置文件路径。

- 与项目同名的目录,包含项目的配置文件。

- __init.py__ 是一个空文件,作用是这个目录可以被当作包使用,也可以做一些初始化操作。

- settings.py 是项目的整体配置文件。

- urls.py 是项目的 URL 配置文件。

- wsgi.py 是项目与 WSGI 兼容的 Web 服务器。

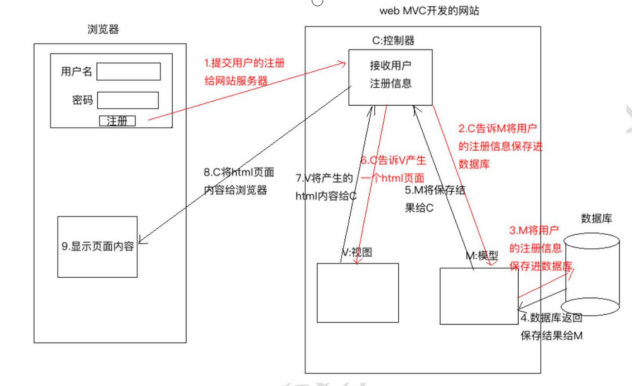

对 MVC,MVT 解读的理解?

MVC:

M:Model,模型,和数据库进行交互

V:View,视图,负责产生 Html 页面

C:Controller,控制器,接收请求,进行处理,与 M 和 V 进行交互,返回应答。

- 用户点击注按钮,将要注册的信息发送给网站服务器。

- Controller 控制器接收到用户的注册信息,Controller 会告诉 Model 层将用户的注册信息保存到数据库

- Model 层将用户的注册信息保存到数据库

- 数据保存之后将保存的结果返回给 Model 模型,

- Model 层将保存的结果返回给 Controller 控制器。

- Controller 控制器收到保存的结果之后,或告诉 View 视图,view 视图产生一个 html 页面。

- View 将产生的 Html 页面的内容给了 Controller 控制器。

- Controller 将 Html 页面的内容返回给浏览器。

- 浏览器接受到服务器 Controller 返回的 Html 页面进行解析展示。

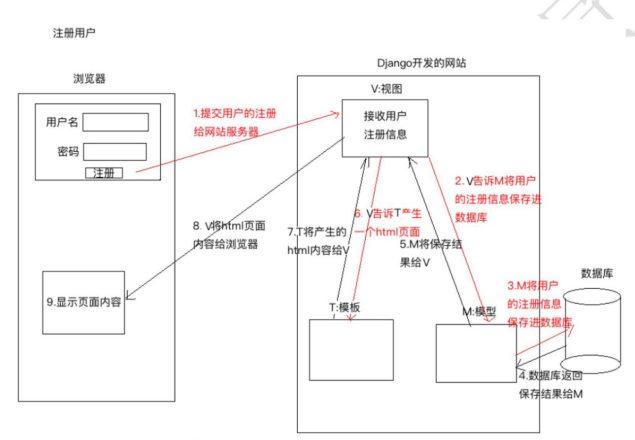

MVT:

M:Model,模型,和 MVC 中的 M 功能相同,和数据库进行交互。

V:view,视图,和 MVC 中的 C 功能相同,接收请求,进行处理,与 M 和 T 进行交互,返回应答。

T:Template,模板,和 MVC 中的 V 功能相同,产生 Html 页面

- 用户点击注册按钮,将要注册的内容发送给网站的服务器。

- View 视图,接收到用户发来的注册数据,View 告诉 Model 将用户的注册信息保存进数据库。

- Model 层将用户的注册信息保存到数据库中。

- 数据库将保存的结果返回给 Model

- Model 将保存的结果给 View 视图。

- View 视图告诉 Template 模板去产生一个 Html 页面。

- Template 生成 html 内容返回给 View 视图。

- View 将 html 页面内容返回给浏览器。

- 浏览器拿到 view 返回的 html 页面内容进行解析,展示。

Django 中 models 利用 ORM 对 Mysql 进行查表的语句(多个语句)?

字段查询:

-

all():返回模型类对应表格中的所有数据。

-

get():返回表格中满足条件的一条数据,如果查到多条数据,则抛异常:MultipleObjectsReturned,查询不到数据,则抛异常:DoesNotExist。

-

filter():参数写查询条件,返回满足条件 QuerySet 集合数据。

-

条件格式:模型类属性名__条件名=值

注意:此处是模型类属性名,不是表中的字段名

-

判等 exact

1. BookInfo.object.filter(id=1) 2. BookInfo.object.filter(id__exact=1)此处的__exact 可以省略 -

模糊查询 like

例:查询书名包含'传'的图书。contains 1. contains BookInfo.objects.filter(btitle__contains=’传’) -

空查询 where 字段名 isnull

1. BookInfo.objects.filter(btitle__isnull=False) -

范围查询 where id in (1,3,5)

1. BookInfo.objects.filter(id__in=[1,3,5]) -

比较查询 gt lt(less than) gte(equal) lte

1. BookInfo.objects.filter(id__gte=3) -

日期查询

1. BookInfo.objects.filter(bpub_date__year = 1980) 2. BookInfo.objects.filter(bpub_date__gt = date(1980,1,1))

-

-

exclude:返回不满足条件的数据。

1. BookInfo.objects.exclude(id=3) -

F 对象:用于类属性之间的比较条件。

1. from django.db.models import F 2. 例:where bread > bcomment BookInfo.objects.filter(bread__gt = F(‘bcomment’)) 3. 例:BookInfo.objects.filter(bread__gt=F(‘bcomment’)*2) -

Q 对象:用于查询时的逻辑条件。可以对 Q 对象进行&|~操作。

1. from django.db.models import Q 2. BookInfo.objects.filter(id__gt=3, bread__gt=30) 3. BooInfo.objects.filter(Q(id__gt=3) & Q(bread__gt=3)) 4. 例:BookInfo.objects.filter(Q(id__gt=3) | Q(bread__gt=30)) 5. 例:BookInfo.objects.filter(~Q(id=3)) -

order_by :对查询结果进行排序。返回 QuerySet

1. 例:BookInfo.objects.all().order_by('id') 2. 例:BookInfo.objects.all().order_by('-id') 3. 例:BookInfo.objects.filter(id__gt=3).order_by('-bread') -

聚合:对查询结果进行聚合操作。

-

aggregate:调用这个函数来使用聚合。返回的是聚合后的数据字典

1. from django.db.models import Sum,Count,Max,Min,Avg 2. 例:BookInfo.objects.aggregate(Count('id')) 3. {'id__count': 5} 注意返回值类型及键名 4. 例:BookInfo.objects.aggregate(Sum(‘bread’)) 5. {‘bread__sum’: 120} 注意返回值类型及键名 -

内置聚合函数:Avg(平均值)、Count(统计个数)、Max(最大值)、Min(最小值)、StdDev(标准差)、Sum(求和)、Variance(方差)

例:统计所有图书的数目。 1. BookInfo.objects.all().count() 例:统计 id 大于 3 的所有图书的数目。 1. BookInfo.objects.filter(id__gt = 3).count()

-

模型类关系

一对多关系

models.ForeignKey() 定义在多的类中

多对多关系

models.ManyToManyField() 定义在哪个类中都可以

一对一关系

models.OneToOneField() 定义在哪个类中都可以

django 中间件的使用?

Django 在中间件中预置了六个方法,这六个方法的区别在于不同的阶段执行,对输入或输出进行干预,方法如下:

-

初始化:无需任何参数,服务器响应第一个请求的时候调用一次,用于确定是否启用当前中间件。

1.def __init__(): 2. pass -

处理请求前:在每个请求上调用,返回 None 或 HttpResponse 对象。

1.def process_request(request): 2. pass -

处理视图前:在每个请求上调用,返回 None 或 HttpResponse 对象。

1.def process_view(request, view_func, view_args, view_kwargs): 2. pass -

处理模板响应前:在每个请求上调用,返回实现了 render 方法的响应对象。

1.def process_template_response(request, response): 2. pass -

处理响应后:所有响应返回浏览器之前被调用,在每个请求上调用,返回 HttpResponse 对象。

1.def process_response(request, response): 2. pass -

异常处理:当视图抛出异常时调用,在每个请求上调用,返回一个 HttpResponse 对象。

1.def process_exception(request,exception): 2. pass

django 开发中数据库做过什么优化?

- 设计表时,尽量少使用外键,因为外键约束会影响插入和删除性能;

- 使用缓存,减少对数据库的访问;

- 在 orm 框架下设置表时,能用 varchar 确定字段长度时,就别用 text;

- 可以给搜索频率高的字段属性,在定义时创建索引;

- Django orm 框架下的 Querysets 本来就有缓存的;

- 如果一个页面需要多次连接数据库,最好一次性取出所有需要的数据,减少对数据库的查询次数;

- 若页面只需要数据库里某一个两个字段时,可以用 QuerySet.values();

- 在模板标签里使用 with 标签可以缓存 Qset 的查询结果。

django 如何提升性能(高并发)?

对一个后端开发程序员来说,提升性能指标主要有两个一个是并发数,另一个是响应时间网站性能的优化一般包括 web 前端性能优化,应用服务器性能优化,存储服务器优化。

对前端的优化主要有:

- 减少 http 请求,减少数据库的访问量,比如使用雪碧图。

- 使用浏览器缓存,将一些常用的 css,js,logo 图标,这些静态资源缓存到本地浏览器,通过设置 http 头中的 cache-control 和 expires 的属性,可设定浏览器缓存,缓存时间可以自定义。

- 对 html,css,javascript 文件进行压缩,减少网络的通信量。

对我个人而言,我做的优化主要是以下三个方面:

- 合理的使用缓存技术,对一些常用到的动态数据,比如首页做一个缓存,或者某些常用的数据做个缓存,设置一定的过期时间,这样减少了对数据库的压力,提升网站性能。

- 使用 celery 消息队列,将耗时的操作扔到队列里,让 worker 去监听队列里的任务,实现异步操作,比如发邮件,发短信。

- 就是代码上的一些优化,补充:nginx 部署项目也是项目优化,可以配置合适的配置参数,提升效率,增加并发量。

- 如果太多考虑安全因素,服务器磁盘用固态硬盘读写,远远大于机械硬盘,这个技术现在没有普及,主要是固态硬盘技术上还不是完全成熟, 相信以后会大量普及。

- 另外还可以搭建服务器集群,将并发访问请求,分散到多台服务器上处理。

- 最后就是运维工作人员的一些性能优化技术了。

启动 Django 服务的方法?

runserver 方法是调试 Django 时经常用到的运行方式,它使用 Django 自带的 WSGI Server 运行,主要在测试和开发中使用,并且 runserver 开启的方式也是单进程 。

怎样测试 django 框架中的代码?

在单元测试方面,Django 继承 python 的 unittest.TestCase 实现了自己的django.test.TestCase,编写测试用例通常从这里开始。测试代码通常位于 app 的 tests.py 文件中(也可以在 models.py 中编写,一般不建议)。在 Django 生成的 depotapp 中,已经包含了这个文件,并且其中包含了一个测试。

用例的样例:

1. python manage.py test: 执行所有的测试用例

2. python manage.py test app_name: 执行该 app 的所有测试用例

3. python manage.py test app_name.case_name: 执行指定的测试用例

一些测试工具:unittest 或者 pytest

有过部署经验?用的什么技术?可以满足多少压力?

- 有部署经验,在阿里云服务器上部署的

- 技术有:nginx + uwsgi 的方式来部署 Django 项目

- 无标准答案(例:压力测试一两千)

Django 中哪里用到了线程?哪里用到了协程?哪里用到了进程?

- Django 中耗时的任务用一个进程或者线程来执行,比如发邮件,使用 celery。

- 部署 django 项目的时候,配置文件中设置了进程和协程的相关配置。

django 关闭浏览器,怎样清除 cookies 和 session?

-

设置 Cookie

1. def cookie_set(request): 2. response = HttpResponse("<h1>设置 Cookie,请查看响应报文头</h1>") 3. response.set_cookie('h1', 'hello django') 4. return response -

读取 Cookie

1. def cookie_get(request): 2. response = HttpResponse("读取 Cookie,数据如下:<br>") 3. if request.COOKIES.has_key('h1'): 4. response.write('<h1>' + request.COOKIES['h1'] + '</h1>') 5. return response -

以键值对的格式写会话

1. request.session['键']=值 -

根据键读取值

request.session.get('键',默认值) -

清除所有会话,在存储中删除值部分

1. request.session.clear() -

清除会话数据,在存储中删除会话的整条数据

1. request.session.flush() -

删除会话中的指定键及值,在存储中只删除某个键及对应的值

1. del request.session['键'] -

设置会话的超时时间,如果没有指定过期时间则两个星期后过期

如果 value 是一个整数,会话将在 value 秒没有活动后过期。

如果 value 为 0,那么用户会话的 Cookie 将在用户的浏览器关闭时过期。

如果 value 为 None,那么会话在两周后过期。

1. request.session.set_expiry(value)

Session 采用的是在服务器端保持状态的方案,而 Cookie 采用的是在客户端保持状态的方案。但是禁用 Cookie 就不能得到 Session。因为 Session 是用 Session ID 来确定当前对话所对应的服务器 Session,而 Session ID 是通过 Cookie 来传递的,禁用 Cookie 相当于失去了 SessionID,也就得不到 Session。

cookie 可以有过期时间,这样浏览器就知道什么时候可以删除 cookie 了。 如果 cookie 没有设置过期时间,当用户关闭浏览器的时候,cookie 就自动过期了。你可以改变SESSION_EXPIRE_AT_BROWSER_CLOSE 的设置来控制 session 框架的这一行为。缺省情况下,SESSION_EXPIRE_AT_BROWSER_CLOSE 设置为 False ,这样,会话 cookie 可以在用户浏览器中保持有效达 SESSION_COOKIE_AGE 秒(缺省设置是两周,即 1,209,600 秒)如果你不想用户每次打开浏览器都必须重新登陆的话,用这个参数来帮你。如果SESSION_EXPIRE_AT_BROWSER_CLOSE设置为 True,当浏览器关闭时,Django 会使 cookie 失效。

SESSION_COOKIE_AGE:设置 cookie 在浏览器中存活的时间。

有用过 Django REST framework 吗?

Django REST framework 是一个强大而灵活的 Web API 工具。使用 RESTframework 的理由有:

- Web browsable API 对开发者有极大的好处

- 包括 OAuth1a 和 OAuth2 的认证策略

- 支持 ORM 和非 ORM 数据资源的序列化

- 全程自定义开发——如果不想使用更加强大的功能,可仅仅使用常规的 function-based views额外的文档和强大的社区支持

简述 Django 下的(内建的)缓存机制?

一个动态网站的基本权衡点就是,它是动态的。 每次用户请求页面,服务器会重新计算。从开销处理的角度来看,这比你读取一个现成的标准文件的代价要昂贵的多。这就是需要缓存的地方。

Django 自带了一个健壮的缓存系统来保存动态页面这样避免对于每次请求都重新计算。方便起见,Django 提供了不同级别的缓存粒度:可以缓存特定视图的输出、可以仅仅缓存那些很难生产出来的部分、或者可以缓存整个网站 Django 也能很好的配合那些“下游”缓存, 比如 Squid 和基于浏览器的缓存。这里有一些缓存不必要直接去控制但是可以提供线索, (via HTTPheaders)关于网站哪些部分需要缓存和如何缓存。

设置缓存:

缓存系统需要一些设置才能使用。 也就是说,你必须告诉他你要把数据缓存在哪里。是数据库中,文件系统或者直接在内存中。 这个决定很重要,因为它会影响你的缓存性能,是的,一些缓存类型要比其他的缓存类型更快速。

你的缓存配置是通过 setting 文件的 CACHES 配置来实现的。 这里有 CACHES 所有可配置的变量值。

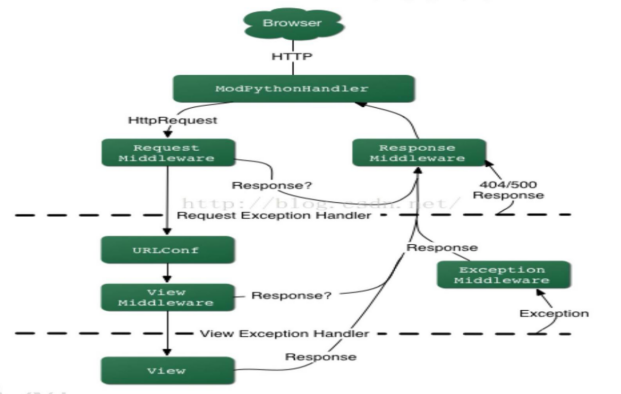

Django HTTP 请求的处理流程?

Django 和其他 Web 框架的 HTTP 处理的流程大致相同,Django 处理一个 Request 的过程是首先通过中间件,然后再通过默认的 URL 方式进行的。我们可以在 Middleware 这个地方把所有Request 拦截住,用我们自己的方式完成处理以后直接返回 Response。

-

加载配置

Django 的配置都在 “Project/settings.py” 中定义,可以是 Django 的配置,也可以是自定义的配置,并且都通过 django.conf.settings 访问,非常方便。

-

启动

最核心动作的是通过 django.core.management.commands.runfcgi 的 Command 来启动,它运行 django.core.servers.fastcgi 中的 runfastcgi,runfastcgi 使用了 flup 的 WSGIServer 来启动 fastcgi 。而 WSGIServer 中携带了 django.core.handlers.wsgi 的 WSGIHandler 类的一个实例,通过 WSGIHandler 来处理由 Web 服务器(比如 Apache,Lighttpd 等)传过来的请求,此时才是真正进入 Django 的世界。

-

处理 Request

当有 HTTP 请求来时,WSGIHandler 就开始工作了,它从 BaseHandler 继承而来。WSGIHandler 为每个请求创建一个 WSGIRequest 实例,而 WSGIRequest 是从http.HttpRequest 继承而来。接下来就开始创建 Response 了。

-

创建 Response

BaseHandler 的 get_response 方法就是根据 request 创建 response,而具体生成response 的动作就是执行 urls.py 中对应的 view 函数了,这也是 Django 可以处理“友好 URL ”的关键步骤,每个这样的函数都要返回一个 Response 实例。此时一般的做法是通过 loader 加载template 并生成页面内容,其中重要的就是通过 ORM 技术从数据库中取出数据,并渲染到Template 中,从而生成具体的页面了。

-

处理 Response

Django 返回 Response 给 flup,flup 就取出 Response 的内容返回给 Web 服务器,由后者返回给浏览器。

总之,Django 在 fastcgi 中主要做了两件事:处理 Request 和创建 Response,而它们对应的核心就是“ urls 分析”、“模板技术”和“ ORM 技术”。

如图所示,一个 HTTP 请求,首先被转化成一个 HttpRequest 对象,然后该对象被传递给Request 中间件处理,如果该中间件返回了 Response,则直接传递给 Response 中间件做收尾处理。否则的话 Request 中间件将访问 URL 配置,确定哪个 view 来处理,在确定了哪个 view 要执行,但是还没有执行该 view 的时候,系统会把 request 传递给 view 中间件处理器进行处理,如果该中间件返回了 Response,那么该 Response 直接被传递给 Response 中间件进行后续处理,否则将执行确定的 view 函数处理并返回 Response,在这个过程中如果引发了异常并抛出,会被 Exception中间件处理器进行处理。

Django 里 QuerySet 的 get 和 filter 方法的区别?

-

输入参数