2023.7.31-2023.8.6暑假第四周博客

2023.7.31

一键启动脚本

启动:

$HADOOP_HOME/sbin/start-yarn.sh

• 从 yarn-site.xml 中读取配置,确定 ResourceManager 所在机器,并启动它

• 读取 workers 文件,确定机器,启动全部的 NodeManager

• 在当前机器启动 ProxyServer (代理服务器)

关闭

$HADOOP_HOME/sbin/stop-yarn.sh

启动:

$HADOOP_HOME/sbin/start-yarn.sh

• 从 yarn-site.xml 中读取配置,确定 ResourceManager 所在机器,并启动它

• 读取 workers 文件,确定机器,启动全部的 NodeManager

• 在当前机器启动 ProxyServer (代理服务器)

关闭

$HADOOP_HOME/sbin/stop-yarn.sh

单进程启停

除了一键启停外,也可以单独控制进程的启停。

• $HADOOP_HOME/bin/yarn ,此程序也可以用以单独控制所在机器的进程的启停

用法: yarn --daemon (start|stop) (resourcemanager|nodemanager|proxyserver)

• $HADOOP_HOME/bin/mapred ,此程序也可以用以单独控制所在机器的历史服务器的启停

用法: mapred --daemon (start|stop) historyserver

除了一键启停外,也可以单独控制进程的启停。

• $HADOOP_HOME/bin/yarn ,此程序也可以用以单独控制所在机器的进程的启停

用法: yarn --daemon (start|stop) (resourcemanager|nodemanager|proxyserver)

• $HADOOP_HOME/bin/mapred ,此程序也可以用以单独控制所在机器的历史服务器的启停

用法: mapred --daemon (start|stop) historyserver

1. 一键启停脚本可用

• $HADOOP_HOME/sbin/start-yarn.sh

• $HADOOP_HOME/sbin/stop-yarn.sh

2. 独立进程启停可用

• $HADOOP_HOME/bin/yarn --daemon

控制 resourcemanager 、 nodemanager 、 proxyserver

• $HADOOP_HOME/bin/mapred --daemon

控制 historyserver

• $HADOOP_HOME/sbin/start-yarn.sh

• $HADOOP_HOME/sbin/stop-yarn.sh

2. 独立进程启停可用

• $HADOOP_HOME/bin/yarn --daemon

控制 resourcemanager 、 nodemanager 、 proxyserver

• $HADOOP_HOME/bin/mapred --daemon

控制 historyserver

2023.8.1

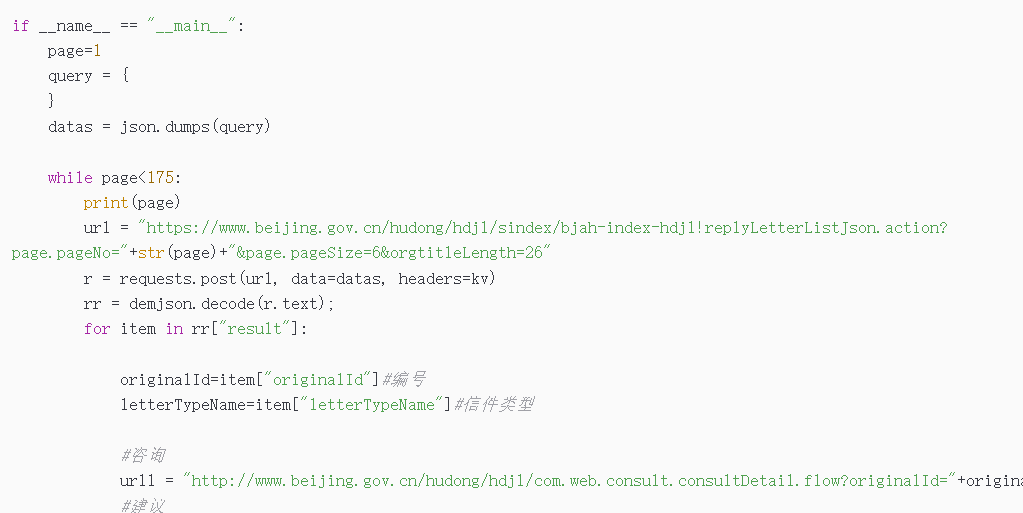

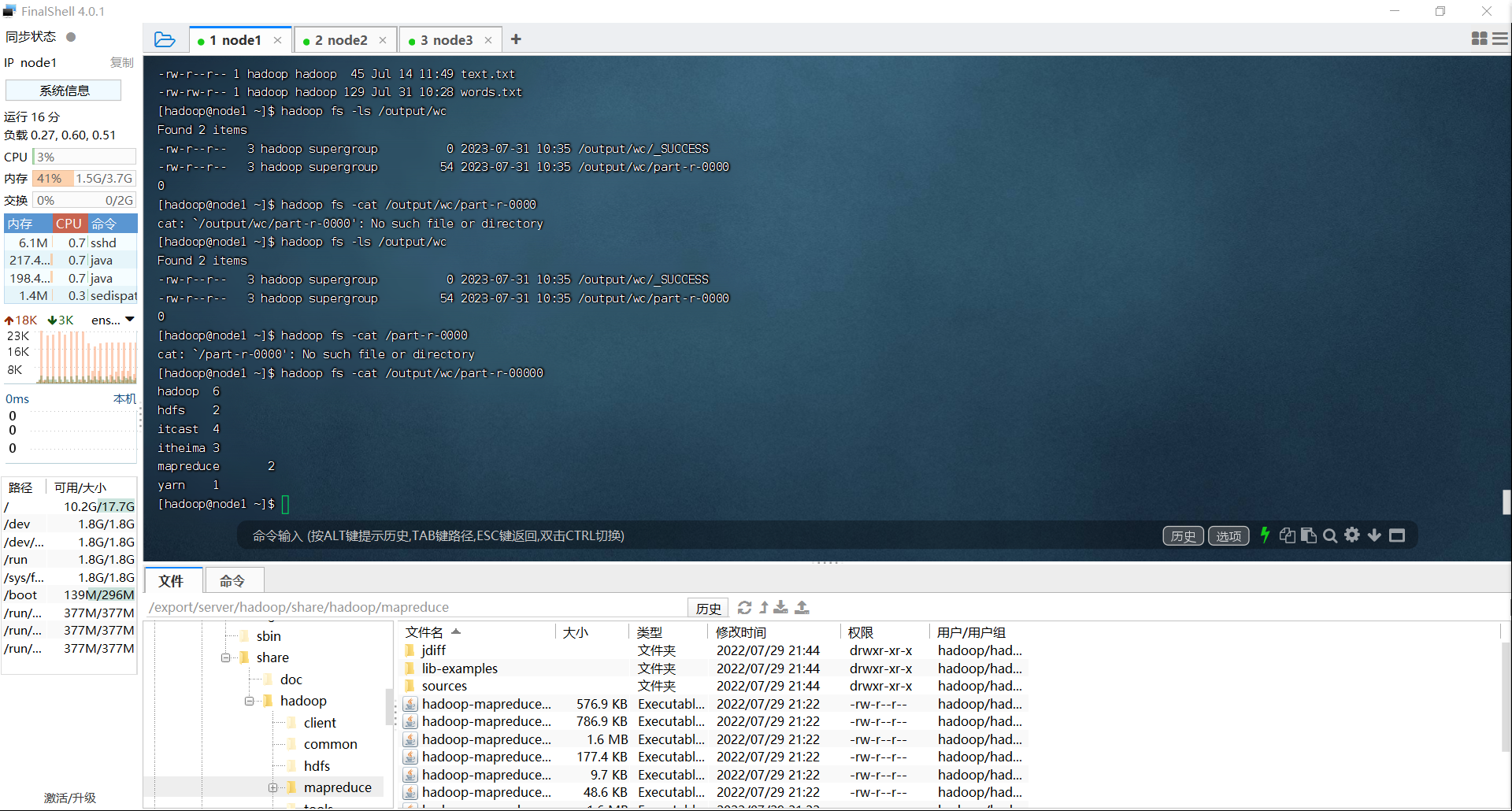

今天联系了提交MapReduce任务到YARN运行

运行了统计文件单词数的应用程序,成功输出了结果,另外计算了圆周率

2023.8.2

对数据进行统计分析, SQL 是目前最为方便的编程工具。

大数据体系中充斥着非常多的统计分析场景

所以,使用 SQL 去处理数据,在大数据中也是有极大的需求

的。

大数据体系中充斥着非常多的统计分析场景

所以,使用 SQL 去处理数据,在大数据中也是有极大的需求

的。

MapReduce 支持程序开发( Java 、 Python

等)

但不支持 SQL 开发

等)

但不支持 SQL 开发

布式 SQL 计算 - Hive

Apache Hive 是一款分布式 SQL 计算的工具, 其主要功能是:

• 将 SQL 语句 翻译成 MapReduce 程序运行

基于 Hive 为用户提供了分布式 SQL 计算的能力

写的是 SQL 、执行的是 MapReduce

Apache Hive 是一款分布式 SQL 计算的工具, 其主要功能是:

• 将 SQL 语句 翻译成 MapReduce 程序运行

基于 Hive 为用户提供了分布式 SQL 计算的能力

写的是 SQL 、执行的是 MapReduce

2023.8.3

如果让您设计 Hive 这款软件,要求能够实现

• 用户只编写 sql 语句

• Hive 自动将 sql 转换 MapReduce 程序并提交运行

• 处理位于 HDFS 上的结构化数据。

如何实现?

• 用户只编写 sql 语句

• Hive 自动将 sql 转换 MapReduce 程序并提交运行

• 处理位于 HDFS 上的结构化数据。

如何实现?

假设要执行: SELECT city, COUNT(*) FROM t_user GROUP BY city;

元数据管理

针对 SQL : SELECT city, COUNT(*) FROM t_user GROUP BY city;

若翻译成 MapReduce 程序,有如下问题:

• 数据文件在哪里?

• 使用什么符号作为列的分隔符?

• 哪些列可以作为 city 使用?

• city 列是什么类型的数据?

针对 SQL : SELECT city, COUNT(*) FROM t_user GROUP BY city;

若翻译成 MapReduce 程序,有如下问题:

• 数据文件在哪里?

• 使用什么符号作为列的分隔符?

• 哪些列可以作为 city 使用?

• city 列是什么类型的数据?

元数据管理

所以,我们可以总结出来第一个点, 即构建分布式 SQL 计算, 需要拥有:

• 元数据管理功能,即:

• 数据位置

• 数据结构

• 等对数据进行描述

进行记录

分布式 SQL 计算

元数据管理 ?

所以,我们可以总结出来第一个点, 即构建分布式 SQL 计算, 需要拥有:

• 元数据管理功能,即:

• 数据位置

• 数据结构

• 等对数据进行描述

进行记录

分布式 SQL 计算

元数据管理 ?

我们称呼它为: SQL 解析器,期待它能做到:

• SQL 分析

• SQL 到 MapReduce 程序的转换

• 提交 MapReduce 程序运行并收集执行结果

• SQL 分析

• SQL 到 MapReduce 程序的转换

• 提交 MapReduce 程序运行并收集执行结果

2023.8.4

今天主要部署了一下hive

首先是安装了mysql,这里出现了一个问题,就是当我按照命令安装的时候出现了问题

mysql的网页无法访问

因此又进行了一些操作 总之是安装并设置好了密码

另外要说的是 linux的操作是真的难用.....

之后就是修改了一下hadoop,需要让hadoop能够代理其他用户和网络用户

具体就是修改了core-site.xml这个文件

然后对hive进行下载和解压,这里我一开始从官网下,但是他的速度实在是太慢了

因此从清华大学的镜像网站下的

之后解压并设置了一个软连接 这些操作和之前部署其他内容都是一样的

之后就是配置mysql

export HADOOP_HOME=/export/server/hadoop

export HIVE_CONF_DIR=/export/server/hive/conf

export HIVE_AUX_JARS_PATH=/export/server/hive/lib

然后对mysql进行了初始化

最后成功启动了hive

2023.8.5

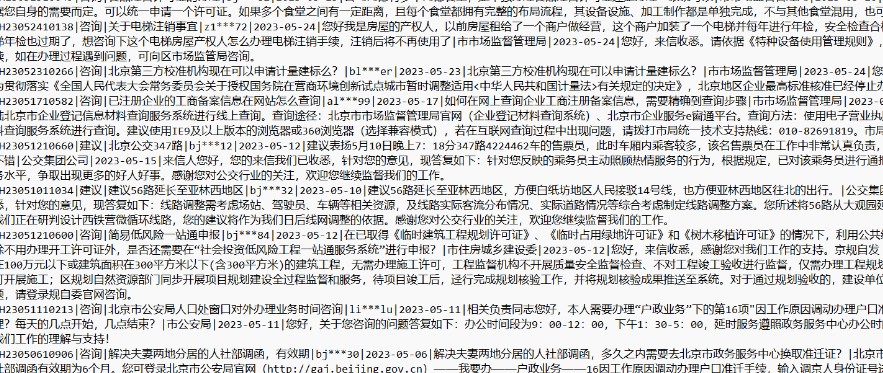

今天主要是做了一下爬虫,爬取到了相关内容