自监督学习

Self Supervised Learning(自监督学习)

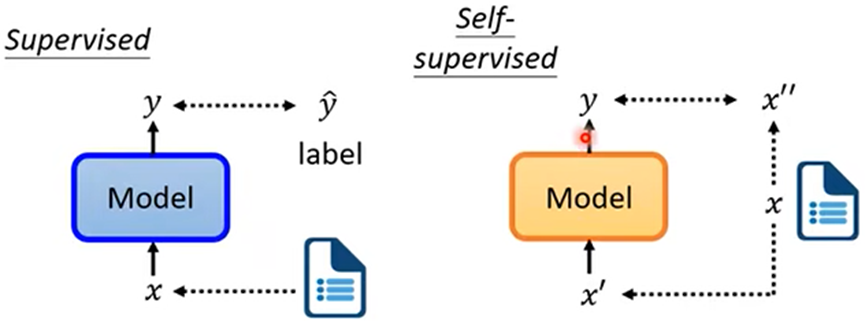

- Supervised Learning(监督式学习):训练资料有标注,通过有标注的资料训练Network

- Self Supervised Learning(自监督学习):训练资料没有标注,将资料x分成x’和x’’两组,一部分x’作为模型的输入,另一部分x’’作为模型的标注,令模型的输出与x’’越接近越好

BERT

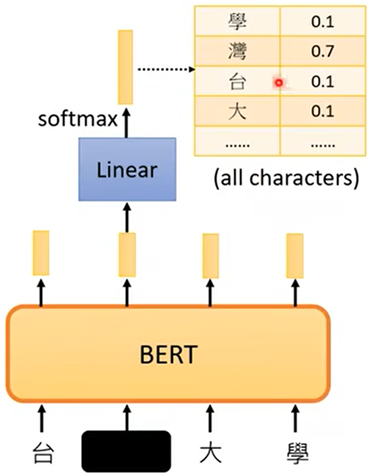

- BERT模型:属于Transform Encoder,一般用在自然语言处理中

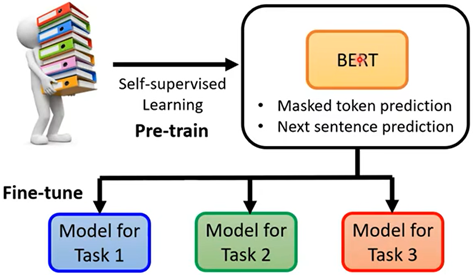

- 训练方式:输入为一排文字(sequence),也可以把输出换成语音、影像,随机把输入中一部分遮盖(把某个字换成特殊符号或其他任意字),训练BERT预测出遮盖的字(自监督学习),训练完的BERT便可以继续做下游任务

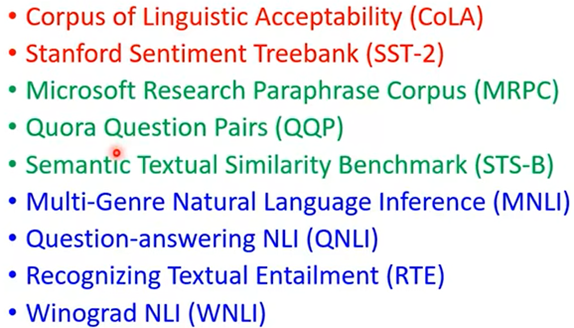

下游任务有很多,GLUE任务集(通过下有任务正确率衡量BERT的好坏)

使用BERT:

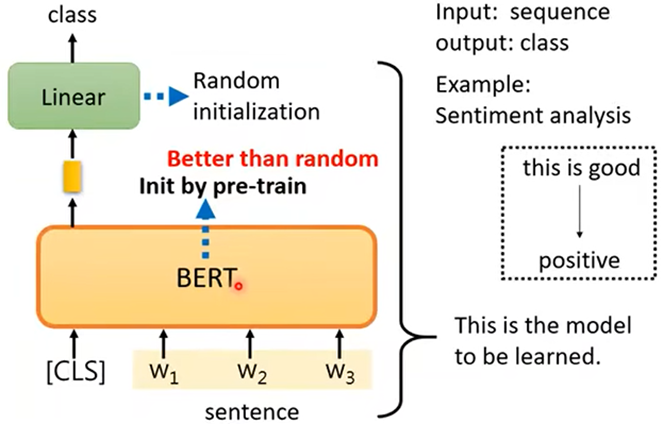

例一:输入一句话,判断这句话正面还是负面(分类)

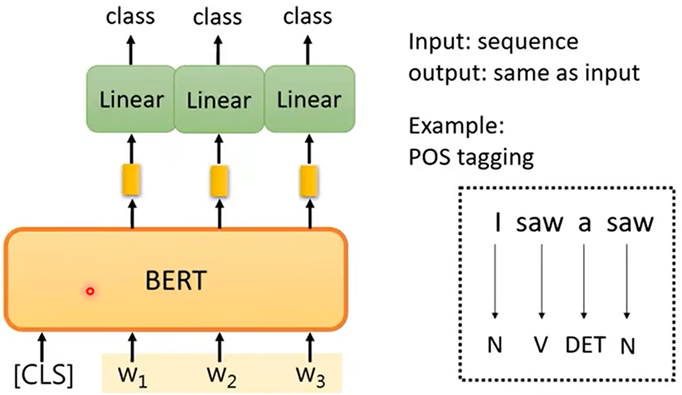

例二:输入一个sequence(序列),输出一个长度相等的sequence;输出句子中每个字对应的词性

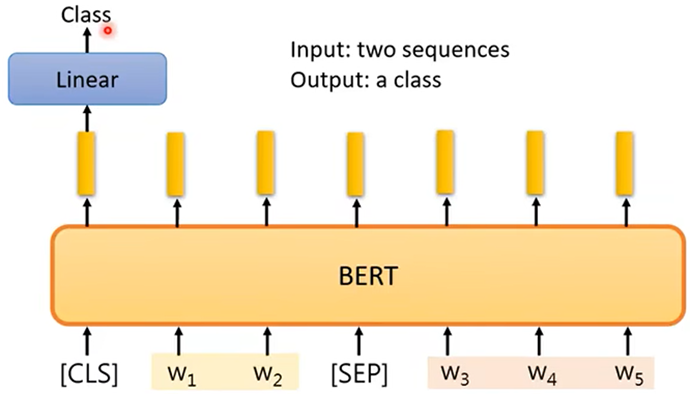

例三:自然语言处理,输入两个句子,分别是条件和结论,输出条件是否能推出结论

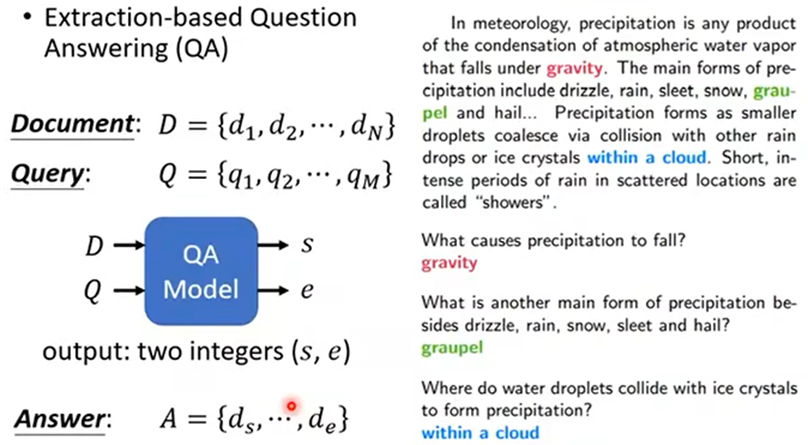

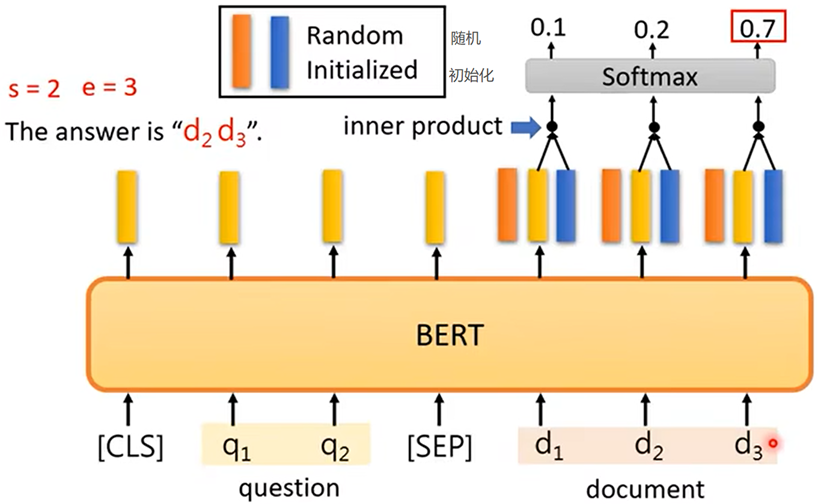

例四:问答系统,给一篇文章,问一个问题,在文章中寻找答案

BERT怎么工作:BERT会对每一个输入的字输出一个向量,并且同一个字会根据上下文可能输出不同的向量(如:‘果’汁、苹‘果’手机),关联型强的字之间向量也相互接近;所以训练BERT是在“理解”每个字。

GPT系列

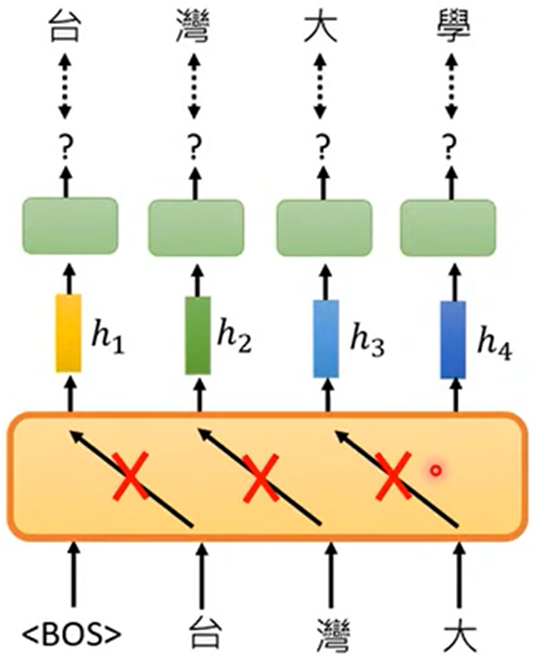

GPT训练时和BERT的目的一样,都是为了理解字,只是方法不一样:

- GPT是输入句子的开头(begin of senten),预测第一个字,然后依次预测之后的每一个字,GPT的模型像是Transform的Decoder部分,预测当前位置只能看之前文字

所以GPT有一定的创造性